小林最近迷上了自己设计智能对话助手,却在调整模型性能时屡屡碰壁。

他刷着社交网络,发现各路达人都在热议“AI微调”的话题,感到好奇,又有些疑惑:究竟怎样微调,才能让他的模型说出“人话”、真正了解用户所需呢?

全量微调:适合大幅度任务变化小林听到有顾问建议,若任务变更幅度大,就得进行“全量微调”。

顾问的说法是,它就像装修房子:从地板到天花板都得重新设计。

每一个模型参数都需要更新,以适应新的功能。

这项技术有点像让我们曾经熟悉的AI变成一个百变怪,不仅能聊天还能做其他任务,比如分析文章或作诗灵感。

这听起来不错,不过顾问也提醒,这种方式耗费资源,不是一般人能轻松驾驭的。

虽说小林有个做程序员的朋友,建议他还是得考虑清晰预算,并评估效果。

冻结层微调:高效利旧你的模型小林却对另一种方法情有独钟:冻结层微调。

顾名思义,冻结底层参数省去了一部分计算烦恼,就好比将模型的底层当作旧菜谱,用过的好东西继续用,只需加些新料在上面。

只需要简单调整上层参数,小林只用少量数据就能让他的AI助手听懂用户的新指令。

而且这种方式还减少过拟合风险,不让模型变得过于复杂或失去本质。

于是,他边锻炼边思索如何高效利用现有资源,让智能助手更智慧、省力地工作。

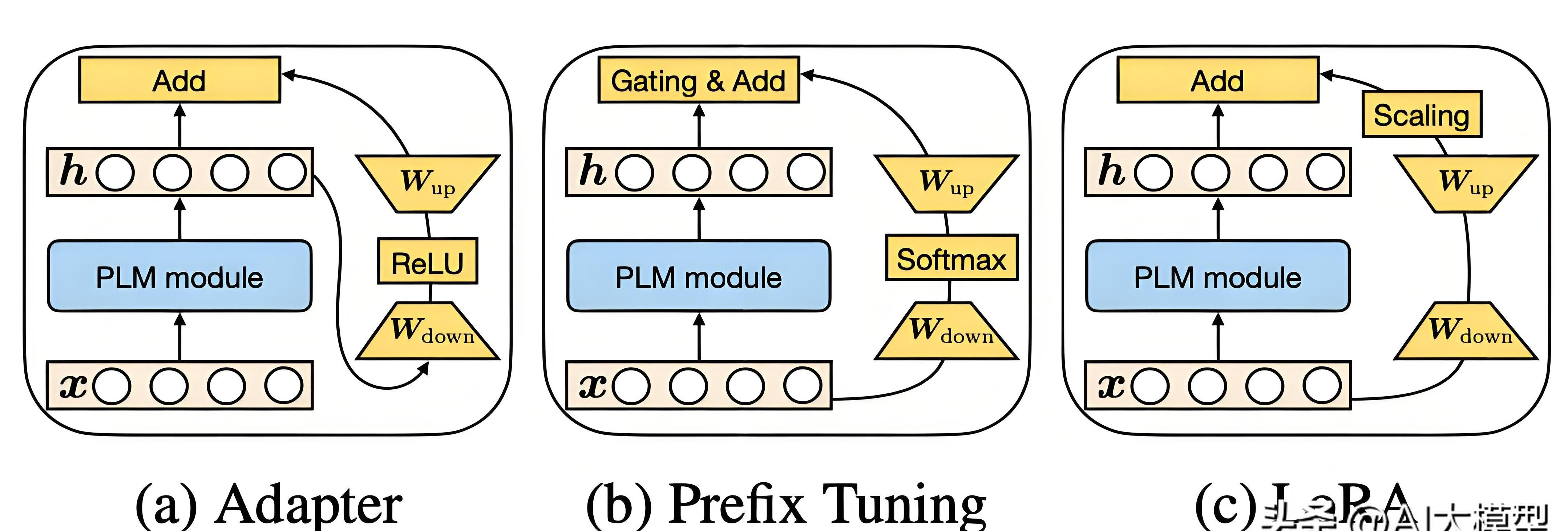

LoRA:让大模型变得轻量高效

沉迷于研究探索,小林发现另一个新潮实用的工具——LoRA。

它不仅能提升模型性能,还比以往方法计算量少。

通过低秩矩阵更新参数这个诀窍,小林仿佛找到了魔术师的秘方——让原本笨重的大模型像穿着轻盈羽衣般地工作。

成本低,自然成为了热门研究的焦点。

小林也因此成功让自己开发的智能助手在同样的计算资源下思维更敏捷,适应各种新场景,用户体验感直线上升。

Prefix Tuning:用前缀引导模型生成不过,前沿领域总有吸引人的新方式,引导性前缀调优就是其中之一。

小林发现,只需在输入序列前加几个像“开场白”一样的前缀,模型行为竟能大大改变。

不需要太多复杂的训练资源,无论小林让助手打招呼还是带领进入相应话题都能从容应对。

不同任务切换变得轻而易举。

说来听惊讶,这种灵活方式让智能助手给用户体验带来耳目一新的感觉,仿佛一位时闻风而动的洒家。

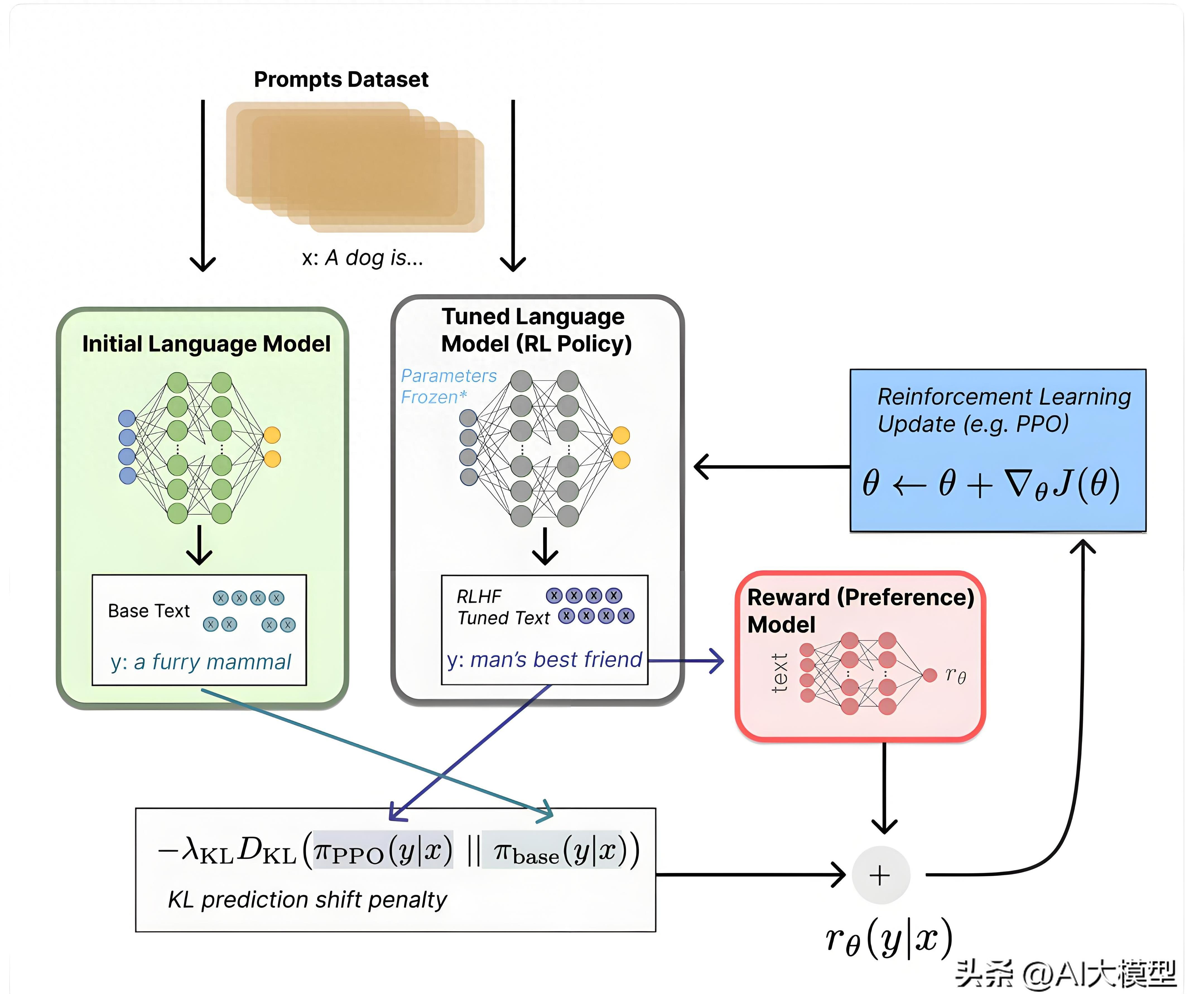

通过一段时间的摸索与调研后,小林总算明白一件事:微调不只是简单的参数调整,它是塑造模型功能的妙法,也是一位开发者必须学会的调味料,让AI变得更贴近生活。

小林不再困惑,他意识到,每一种微调方法有它独特价值,依据具体需求灵活选择,才能让智能助手始终保持优质服务体验。

结尾,也许AI的建设就如同社区营造,总要根据变化调整布局与方位。

而微调正是这种新变革的重要部分,赋予创作生命力,让未来科技的变迁更加融入日常。

小林的探索也许只是个开始,也许离完美还有些距离。

但他正一步步接近心中理想:创造一个能真正理解人们心声的AI,获得无数人的认同与喜爱。

未来,AI微调的故事一定会引领更多技术爱好者一起探索,继续演绎属于他们的智慧生活。