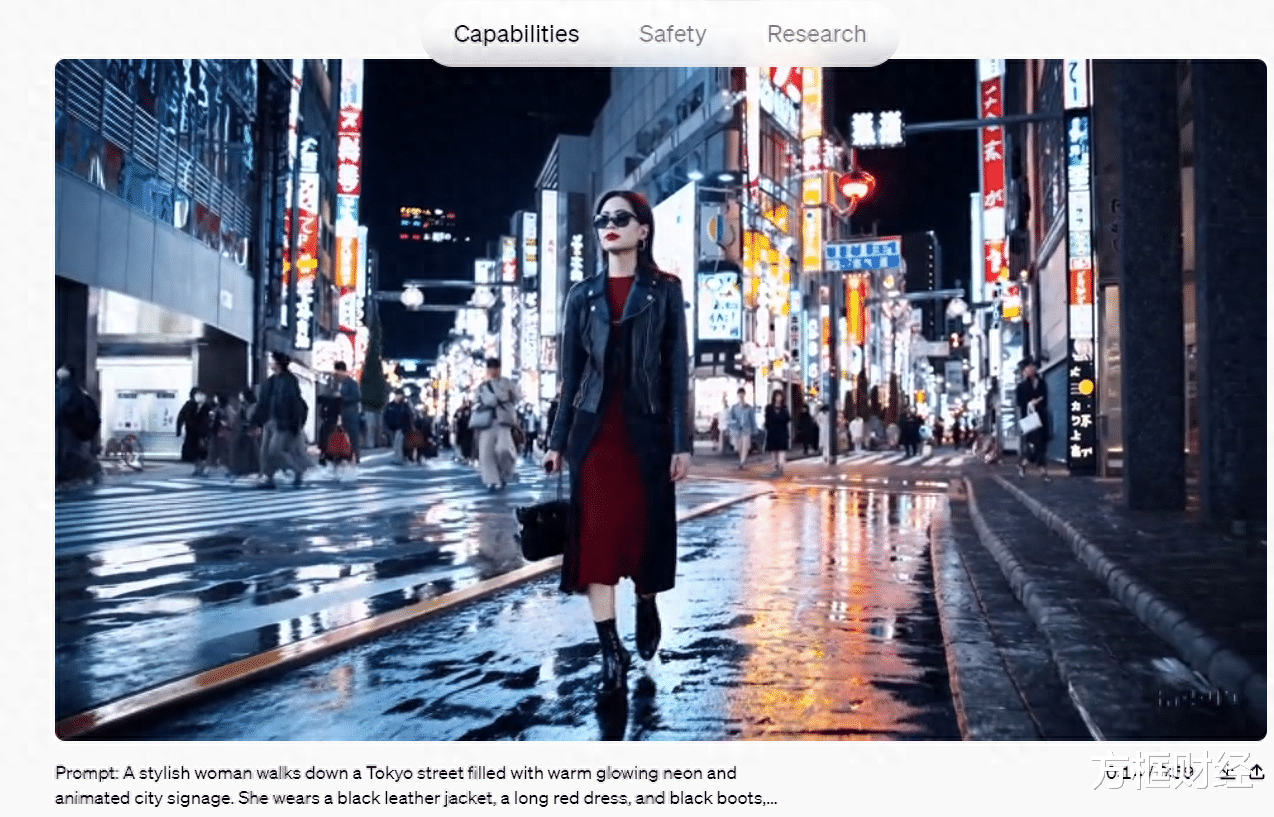

OpenAI 正在推出一种新的视频生成模型,它的名字叫 Sora。这家人工智能公司称,Sora"可以根据文字说明创建逼真而富有想象力的场景"。文本到视频模式允许用户根据自己编写的提示创建长达一分钟的逼真视频。

根据 OpenAI 的介绍博文,Sora 能够创建"具有多个角色、特定运动类型以及主体和背景准确细节的复杂场景"。该公司还指出,该模型能够理解物体"在物理世界中的存在方式",还能"准确解释道具并生成表达生动情感的引人注目的角色"。

该模型还能根据静态图像生成视频,以及在现有视频中填充缺失的帧或扩展视频。OpenAI 的博文中包含的 Sora 生成的演示包括淘金热时期加利福尼亚州的空中场景、从东京火车内部拍摄的视频等。许多演示视频仍有人工智能的痕迹--比如在一段博物馆的视频中,地板疑似在移动。OpenAI 表示,该模型"可能难以准确模拟复杂场景的物理现象",但总体而言,演示结果令人印象深刻。

几年前,像 Midjourney 这样的文本到图像生成器在模型将文字转化为图像的能力方面处于领先地位。但最近,视频技术开始飞速进步:Runway 和 Pika 等公司都展示了自己令人印象深刻的文字转视频模型,而Google的 Lumiere 也将成为 OpenAI 在这一领域的主要竞争对手之一。与 Sora 类似,Lumiere 也为用户提供了文字转换视频的工具,还能让用户通过静态图像创建视频。

Sora 系统目前只对"红队"人员开放,他们负责评估模型的潜在危害和风险。OpenAI 还向一些视觉艺术家、设计师和电影制片人提供访问权限,以获得更多反馈意见。一些研究人员指出,现有模型可能无法准确模拟复杂场景的物理现象,也可能无法正确解释某些因果关系。

本月早些时候,OpenAI 宣布将在其文本到图像工具 DALL-E 3 中添加水印,但指出这些水印"很容易去除"。与其他人工智能产品一样,OpenAI 将不得不面对人工智能逼真视频被误认为是真实视频的后果。

想多了,谁愿意天天看假视频?