阿里巴巴研究团队近日发布了一款名为“EMO(Emote Portrait Alive)”的 AI 框架,输入一张参考图像和声音音频,该框架能够生成具有丰富面部表情和头部姿势的声音肖像视频,支持中英韩等语言。

概要:一种富有表现力的音频驱动的肖像视频生成框架。输入单个参考图像和声音音频,例如说话和唱歌,我们的方法可以生成具有表情丰富的面部表情和各种头部姿势的声音头像视频,同时,我们可以根据输入视频的长度生成任意持续时间的视频。 方法:我们的框架主要由两个阶段组成。在称为帧编码的初始阶段,ReferenceNet 用于从参考图像和运动帧中提取特征。随后,在扩散过程阶段,预训练的音频编码器处理音频嵌入。面部区域掩模与多帧噪声集成以控制面部图像的生成。接下来是使用主干网络来促进去噪操作。在主干网络中,应用了两种形式的注意力机制:参考注意力和音频注意力。这些机制分别对于保留角色的身份和调节角色的动作至关重要。此外,时间模块用于操纵时间维度,并调整运动速度。

方法:我们的框架主要由两个阶段组成。在称为帧编码的初始阶段,ReferenceNet 用于从参考图像和运动帧中提取特征。随后,在扩散过程阶段,预训练的音频编码器处理音频嵌入。面部区域掩模与多帧噪声集成以控制面部图像的生成。接下来是使用主干网络来促进去噪操作。在主干网络中,应用了两种形式的注意力机制:参考注意力和音频注意力。这些机制分别对于保留角色的身份和调节角色的动作至关重要。此外,时间模块用于操纵时间维度,并调整运动速度。

EMO 这一基于英伟达的音频到视频生成框架。EMO 使用了超过 250 小时的专业视频 进行训练,以构建相关的 AI 框架。研究团队还分享了一些由 EMO 框架生成的 DEMO 演示片段,并在 ArXiv 上发布了模型的工作原理。如果您对此感兴趣,可以访问 GitHub 查看项目

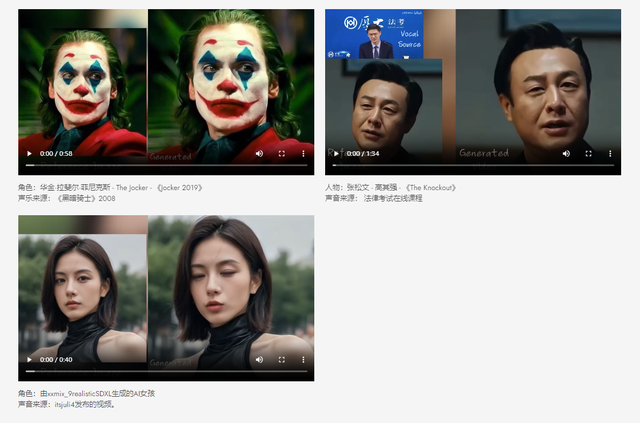

官网:https://humanaigc.github.io/emote-portrait-alive/视频生成效果:

根据研究人员的称述,他们引用了多项实验结果来支持他们的观点,声称EMO有能力产生令人信服的说话视频,并且能够生成不同风格的歌唱视频。他们将EMO与其他竞争产品如DreamTalk、Wav2Lip和SadTalker进行比较,并称EMO在这些方面表现出显著的优势。