多模态大模型技术白皮书

多模态大模型突破传统语言模型的局限,不再仅处理文本信息。它们能够整合语音、图像、视频等多种感知数据,实现全面学习。这种融合多种感知途径和表达形式的技术,能够同时处理和理解来自各种感官通道的信息,并以多模态方式呈现输出,为人工智能领域带来革命性的进步。

1.1 多模态大模型的技术体系

现有多模态大模型包括:1. 面向理解任务;2. 面向生成任务;3. 兼顾理解与生成;4. 知识增强型。

1.1.1 面向理解任务的多模态大模型

面向理解任务的多模态大模型,核心结构通常基于Transformer编码器。根据模型结构差异,这类模型可分为单流与多流两类。单流结构中,各模态特征经拼接后由单一共享Transformer网络处理;而多流结构中,各模态特征分别由独立Transformer网络编码,这些网络间存在特征交互融合机制。

ViLBERT,作为多流结构的典范,采用了双流Transformer架构。该模型将文本和图像数据独立输入两个Transformer编码器,然后利用Co-Attention Transformer层融合两者特征。这样得到的文本-图像特征可用于视觉问答、图像描述生成等多模态任务。

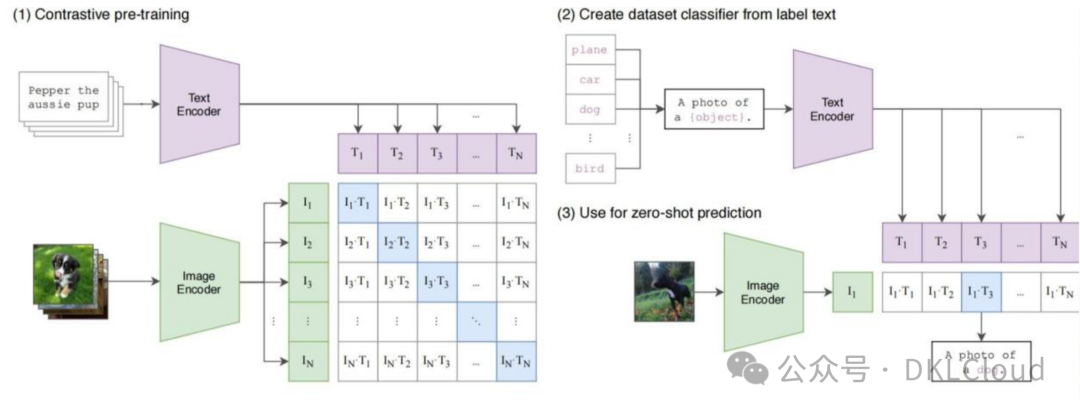

CLIP模型,源自OpenAI,是多流结构的典范。它将图像和文本特征抽取分开处理,再通过对比学习将两者融为一体。基于4亿图文对的训练,CLIP在自然语言监督中习得视觉概念,展现出卓越的零样本分类能力。

ALIGN,一种与CLIP类型相似的先进方法,通过对比损失训练了一个简洁的双编码器模型。利用超过10亿个包含噪声图像-文本对的数据集,扩展了视觉和语言表征学习。CLIP采用图文双流设计,而VATT则针对视频-文本-音频数据构建了多流模型。

VATT采用了与CLIP类似的方法,将每个模态投影为特征向量,并通过对比学习在语义分层的不同粒度空间中训练模型。

图 3-1 CLIP模型架构图

VL-BERT是一种单流结构的多模态预训练模型,它将图像的描述文本和关键物体的区域特征拼接后作为BERT网络的输入,通过掩码掉部分文本输入和图像输入并预测所缺失的信息来进行模型训练。

UNITER是一种多任务的多模态预训练方法,相较于其他方法,其独特的单词与图像区域匹配模块能更有效地构建图像与文本之间的精细联系。

在视频领域,两大主流方法分别是VideoBERT和ActBERT。VideoBERT,作为一款视频-语言模型,将文本与视频信息融合于BERT网络中;而ActBERT则采用了全局-局部关系建模策略,不仅利用全局信息加强理解,还通过分析视频帧中的局部细节以深化对视频内容的理解。

现有的多模态大模型主要分为两类结构,为理解任务提供基础。除此之外,研究者们还探索了预训练任务的方法,如引入更多任务或统一架构进行训练。Florence 是一个典型实例,专注于使模型适应各种下游任务,并构建了一个由多模态大模型和适应模型组成的工作流。

1.1.2 面向生成任务的多模态大模型

目前,主要的图像生成方法集中在序列生成模型和扩散模型两大类。在这其中,DALL-E[73]以其卓越的表现成为了业界的翘楚。该模型由OpenAI开发,基于4亿对图文数据进行训练,采用VQVAE图像自编码器与GPT的组合架构,成功在图像生成任务中展现出卓越的质量和广泛的泛化能力,堪称图像领域的"图像版GPT"。

CogView模型,源自北京智源研究院(如图3-2所示),是另一个典型的图像生成模型。它与DALL-E相似,但专为中文环境设计,能够实现文本到图像的生成。CogView模型进一步探索了多模态生成模型在下游任务上的精调泛化能力,为中文环境提供了强大的图像生成解决方案。

CogView在文本控制的样式学习、服装设计和图像超分等任务上表现卓越。在文本生成领域,序列生成模型如GIT成为主流方案。GIT是一个多模态大模型,整合了图像/视频的描述和问答等视觉语言任务。它包含一个图像编码器和一个文本解码器,后者在视觉编码基础上,通过自回归方式生成文本。

图 3-2 CogView 模型架构图

扩散模型是一种通过连续添加高斯噪声来破坏训练数据,然后通过反转这个噪声过程来学习恢复数据的模型。其中,LDM是一种代表性方法,它先压缩图像的像素信息来获取图像对应的隐特征表达,再采用扩散模型来建模图像隐特征分布。

Stable Diffusion,作为开放领域的文本至图像生成扩展LDM的典范,是开源模型的翘楚。然而,在闭源领域中,OpenAI的DALL-E2与谷歌的Imagen也展现出卓越的性能。

DALL-E2通过反转CLIP图像编码器并训练一个独立的映射模型,实现了从文本到图像的生成。这一创新方法显著提高了输入文本与生成图像之间的匹配度。

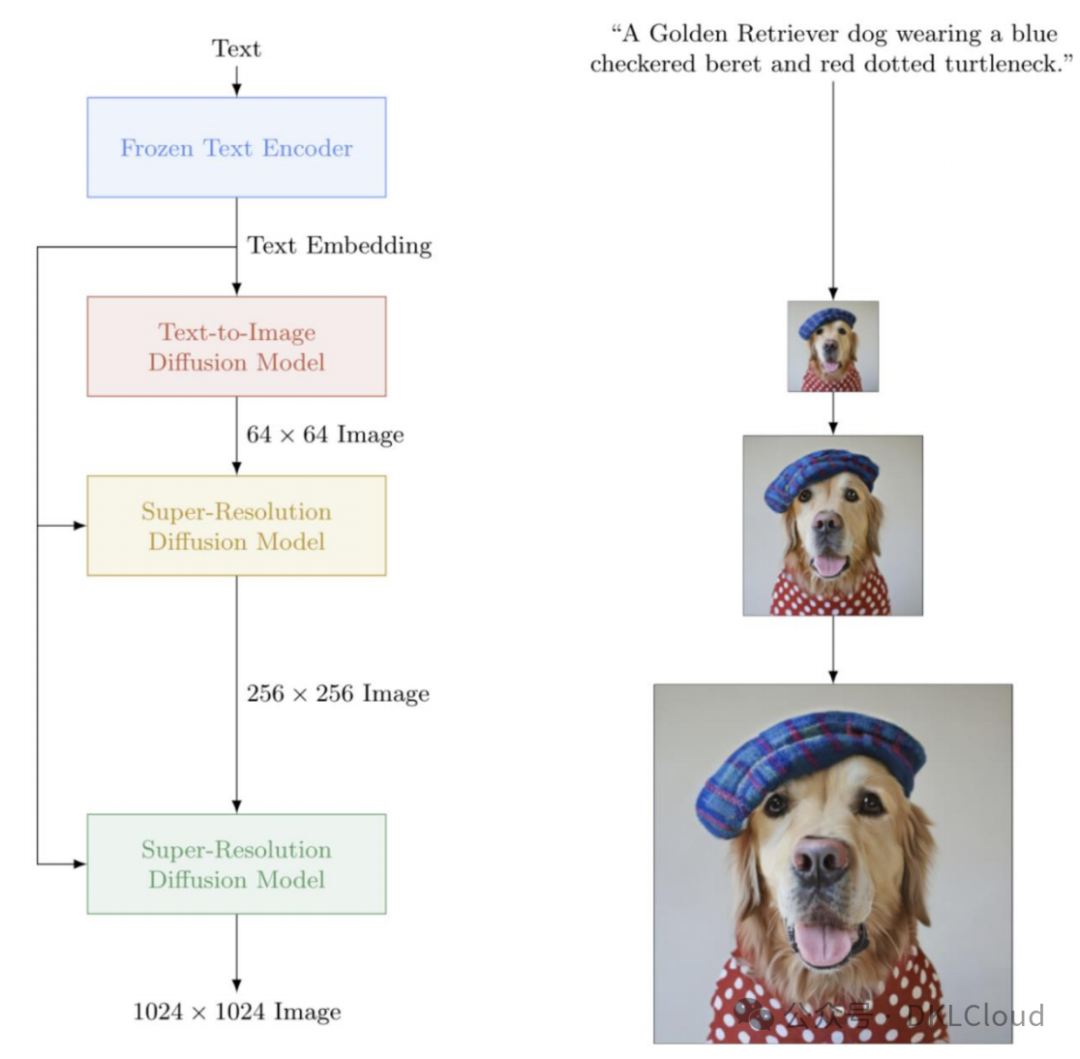

Imagen首先将文本转化为编码表示,接着采用扩散模型将其转换为64x64像素的低分辨率图像。最后,通过两个超分辨率扩散模型逐步提升分辨率至1024x1024像素,如图3-3所示。

Imagen,一款强大的图像生成模型,摒弃了DALL-E2的方法,采用通用语言大模型T5进行文本信息编码。与CLIP相比,基于T5提取的文本特征生成的图像细节准确度更高,呈现出更为精细的视觉效果。

图 3-3 Imagen 模型架构图

1.1.3 兼顾理解和生成任务的多模态大模型

"Transformer模型的编码器和解码器各具特色。编码器借助双向注意力深化对数据的理解,而解码器则通过单向注意力技术提升生成能力。"

为了让模型具备理解与生成能力,我们可以结合Transformer编码器与解码器,打造一种多模态大模型,从而在更广泛的下游任务中发挥作用。

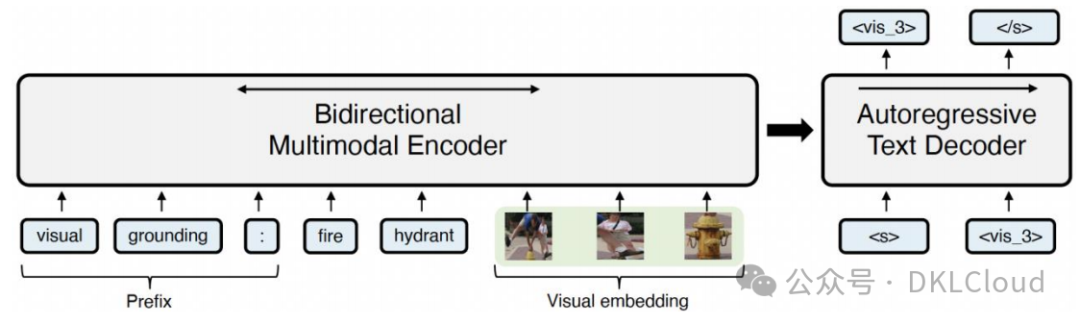

一种典型的方法是蒙特利尔大学的VL-T5模型,该模型将多种多模态任务统一为文本生成任务。如图3-4所示,VL-T5模型由Transformer编码器和自回归解码器构成。其主要创新在于针对训练任务和数据的不同,采用不同的输入文本与输出文本构造方式。这种将模型结构与目标任务统一的方法能充分利用各种任务的数据来训练模型,从而提高模型的泛化能力。

"Unified VLP,一种典型的方法,特色在于其编码器和解码器均位于同一Transformer网络中。"

该方法通过设置注意力掩码来控制网络为编码器或解码器。

编码器和解码器的注意力掩码在功能上有显著差异。编码时,双向掩码使网络能够捕捉前后两个方向的依赖关系;而解码时,单向掩码仅允许建模前文的依赖关系。这种独特的编解码共享策略有助于降低模型参数量,从而实现更简洁高效的网络结构。

图 3-4 VL-T5 模型架构图

结合语言大模型的文本生成与多模态编码器的感知能力,打造出兼具理解与生成能力的多模态大模型。这种方法以语言大模型为主导,实现多模态对齐、融合和交互。

文本具有高效的表达效率,能通过语义描述与多模态建立直接联系。此外,语言大模型预训练过程中学习了丰富的世界知识,具备潜在理解多模态信息的能力。

这种模型主要由单模态编码器、连接器和语言大模型三部分构成。为降低计算复杂度和提升训练效率,可对单模态编码器和语言大模型的参数进行冻结。连接器方面,常见的有线性映射层或特殊设计的网络模块,如 BLIP-2 中的 Q-former 结构(如图 3-5 所示)。

这种模型包括两个训练阶段。首先,通过大规模弱关联的跨模态数据(如图像-文本、视频-文本、音频-文本等),利用条件文本生成任务使各个模态与语言大模型达到语义对齐。

在第二阶段,我们致力于提升零样本多模态能力,关键在于构建适应多模态任务的指令微调数据。目前,常见的多模态指令微调数据类型包括多模态对话、详细描述以及推理问答等。

图 3-5 BLIP-2 模型架构图

1.1.4 知识增强的多模态大模型

大模型在处理大规模数据方面表现优异,同时具备学习隐式知识的能力。为实现更有意义的理解和预测,需探索将隐式知识与显式知识(如知识图谱)相结合的方法。因此,将结构化知识信息(如知识图谱、场景图、外部知识库等)融入大模型,有助于提升多模态大模型的知识利用能力。

在多模态学习领域,百度的ERNIE-ViL模型展示了一种创新的方法。如图3-6所示,该模型将文本解析得到的场景图信息融入视觉-语言模型中,通过在预训练阶段掩码场景图中的实体和关系,引导模型预测被掩码的知识信息。这种细粒度的任务设计使得模型能更精确地捕捉图像与文本间的对齐信息,从而优化多模态理解。

在知识图谱的应用上,KRISP方法是一种优秀示范。它融合了隐性与显性的知识获取途径,从无监督语料和有监督训练数据中提炼隐性知识,同时从结构化的知识图谱中汲取明确的符号信息。如此一来,既能进行知识的隐式推理,又能掌握知识的明确表达。

图 3-6 ERNIE-ViL 模型架构图

1.2 多模态大模型的关键技术

1.2.1 多模态大模型的网络结构设计

在处理图像和文本模态时,我们通常使用Transformer或卷积神经网络(CNN)来捕捉视觉与语言间的复杂联系。而对于事件流,脉冲神经网络因其时序动态模拟能力而更受欢迎。

随着模型规模的扩大,多模态大模型展现出惊人的记忆力和性能提升。然而,复杂性的增加也带来了计算效率的挑战,甚至可能导致性能瓶颈。因此,优化网络模型结构,如改进或创新Transformer设计,已成为研究的关键方向。

其次,多模态大模型兴起,以语言为核心构建。例如,DeepMind的Flamingo视觉语言模型,能将图像、视频和文本作为输入,生成相关语言回应。

它将视觉编码器与语言大模型的参数冻结并通过可学习的融合模块联系起来,模型采用20 多亿对图片-文本、270 万对视频-文本,与 430 万图文混排的网页数据进行视觉-语言联合训练;Flamingo 具有少样本(few-shot)的多模态序列推理能力,无需额外训练即可完成视觉语义描述、视觉问答等多种任务。另一个代表性模型 KOSMOS-1,它将一个基于Transformer 的语言模型作为通用接口,并将其与视觉感知模块对接,使得模型“能看”和“会说”;该模型具有 16 亿参数量,在大规模多模态语料库上训练,具有遵循指令(即零样本学习)以及在上下文中学习(即少样本学习)能力,能够原生处理视觉对话、视觉问答、图像描述生成、光学字符识别等任务。

近期,模型探索将图像、视频等感知模块与 LLaMA等开源语言大模型结合,实现类似GPT-4的多模态理解。

ChatBridge,作为典型模型,采用多感知模块对图片、音频、视频等多元特征进行处理。预训练参数的运用,将这些模态信息投影至语言大模型的语义空间,赋予模型理解和灵活处理混合模态信息的能力。

对于多模态预训练,设计兼容下游任务的网络结构至关重要。引入编码器-解码器结构将多模态理解与生成统一,支持各种多模态任务。涉及跨模态注意机制、模态对齐和翻译,以及复杂的特征集成策略。

1.2.2 多模态大模型的自监督学习优化

多模态大模型常用的自监督学习任务通常有以下几种类型:

- 对比学习

- Masked Autoencoder(MAE)

- Self-Supervised Multi-Domain Adaptation(SSDAM)

- Multi-Domain Adversarial Training(MDAT)

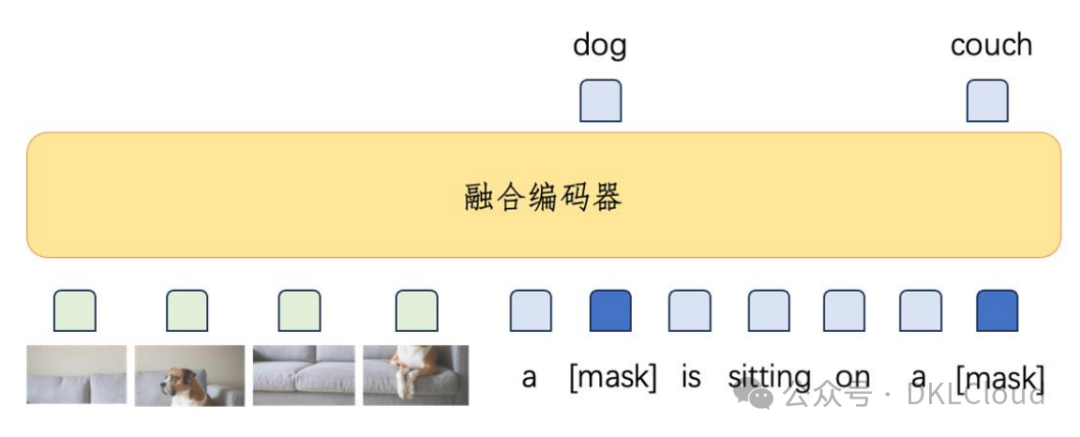

掩码语言建模(Masked Language Modeling,MLM)是一种预训练模型的方法,它将输入文本序列中的某些单词或标记替换为特殊的掩码标记[MASK]。这种方法要求模型根据可见的多模态上下文来预测这些被遮蔽的单词或标记,如图3-7所示。

多模态大模型通过预训练任务,提升了对大规模文本数据的深度语言理解能力,从而优化了下游自然语言处理任务,如文本分类、命名实体识别和句子相似性计算等。

图 3-7 掩码语言预测

掩码图像建模(Masked Image Modeling,MIM)是一种预训练模型,它可以预测或还原输入图像中的被遮蔽区域。在该模型中,部分区域会被隐藏或替换为特殊的掩码标记[MASK],然后预训练模型被要求在仅看到其余图像内容与文本等其他模态信息的情况下进行预测或还原。

"多模态大模型学习过程,融合图像视觉特征、上下文信息及语义关系以深化对图像内容的理解。详见图3-8。"

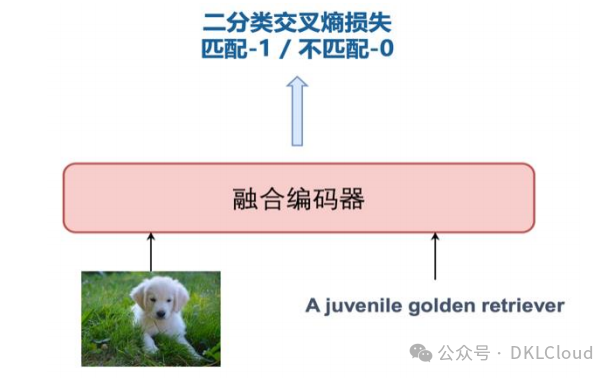

图 3-8 掩码视觉预测

图像-文本匹配(ITM)是一种旨在实现图像与文本的全局对齐的任务。通常,给定图文对作为正样本,随机配对作为负样本对,然后通过二分类方法实现图像和文本的匹配,从而建立图像和文本之间的语义关联。这种技术可以用于许多应用程序,例如图像检索、自动标注和视觉问答等。

图 3-9 图像文本匹配

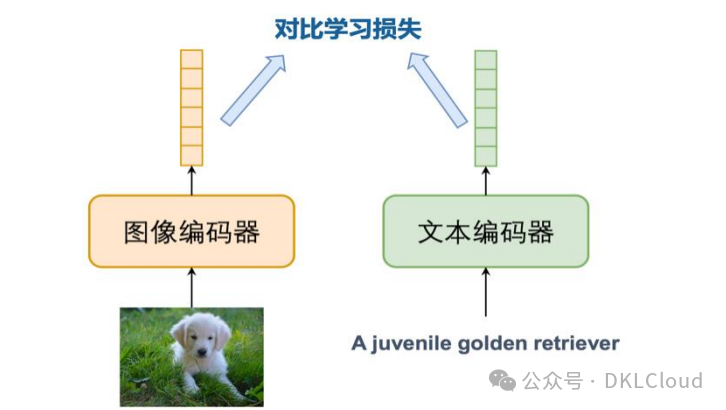

"图像-文本对比学习(ITC)是一种先进的技术,它采用对比学习策略来深化图像与文本之间的语义联系。通过将具有相同内容的图像和文本样本对的向量表示紧密相连,而将不同内容的样本对的向量表示推离,这种方法有效地提升了图像和文本之间的关联性。此策略使得模型能够更深入地理解图像和文本间的语义联系,从而为处理多模态任务提供了更强的表达能力。如图3-10所示,这一技术的优势得以直观呈现。"

图 3-10 图像-文本对

1.2.3 多模态大模型的下游任务微调适配

多模态大模型的微调适配方式主要有三种:LoRA(Low Rank Adaptation)、适配器调整(Adapter Tuning)和前缀调整(Prefix Tuning)。这些方法都有各自的优缺点,可以根据具体的应用场景进行选择。

针对特定任务的模型微调:多模态大模型初始权重,基于特定任务数据进行有监督微调。模型学习细粒度特征和表示,以适应任务需求。

2) 联合提示学习的模型微调适配:通过设计适应上游预训练任务的模板,挖掘预训练模型潜力,实现下游任务在尽量无标注数据的情况下的良好完成。提示学习使预训练模型在不同任务上重复使用,仅需调整提示模板以适应特定任务,从而节约训练时间和计算资源。

基于适配器网络的模型微调适配是一种新型的模型微调方法,它可以让模型在不同任务之间共享通用预训练模型的表示,同时在每个任务上进行个性化的调整。这种方法通常由较少的参数组成,因此它们比在整个模型上进行微调更加高效。在训练过程中,预训练模型的参数是固定的,只有适配器层的参数被更新。

现有预训练大型模型通过特征微调或提示学习应用于下游任务,但仍需探索更多增量学习算法以适应多模态领域。为应对未来新传感器(模态)的出现,设计灵活的多模态大型模型具有重要意义。

-对此,您有什么看法见解?-

-欢迎在评论区留言探讨和分享。-