最近汇总了一下18家部署了第三方满血版DeepSeek R1模型,并推荐了8家值得个人尝鲜的。

由于工作比较忙,也没办法一直在多个云服务后台使用。(因为云后台会让你不停的重新登陆,很烦)

所以,我实际使用的就是用Chrome浏览器的插件Page Assist作为客户端,以API的方式调用R1模型。(如果有找不到插件的朋友,也可以留言问我要网盘链接)

之前看到青云CoresHub官方教程推荐Chatbox作为客户端,但Chatbox的实际体验远远不如Page Assist。

在Page Assist中调用第三方DeepSeek-R1的API(熟悉Page Assist的朋友可跳过)

上图是Page Assist的初始页面。报错是因为,它经常搭配Ollama使用,用户在本地安装Ollama运行模型之后,就可以直接在左上角看到运行的模型。

之前也说过了,从个人使用体验来讲,想要愉快的聊天基本不要考虑用本地蒸馏的模型,蒸馏模型简直就是智障,根本没法聊。

想要配置第三方满血版DeepSeek-R1的API,就需要点右上角的设置按钮,切换到“OpenAI兼容API”选项。不习惯英文页面的在这里切换语言。

点击右上角“添加提供商”按钮,会弹出新的窗口,随意填写“提供商名称”,然后,配置好“基础URL”,基础URL可直接复制:

https://openapi.coreshub.cn/v1

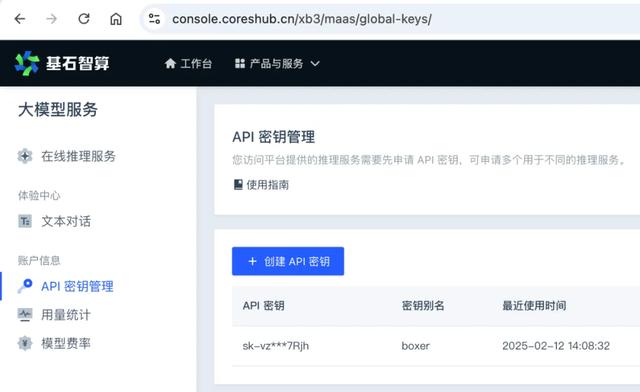

然后,找到上图的页面创建API秘钥,把秘钥贴在这里,就能看到可使用的模型了。

然后,用户可以自行选择打算使用的模型,最后点保存即可。不建议选太多,不然用的时候看得眼花。

除了用青云的CoresHub以外,我还用了腾讯云的满血版DeepSeek R1的API,逻辑也是一样,不再赘述。

(重点)使用第三方满血版DeepSeek R1一定要做好这个设置

如果配置好了之后,就可以在左上角看到模型选择的下拉列表。这时候,点击右侧的花朵一样的按钮。

这里需要做2个关键设置:

第一个关键设置,在临时系统提示词框里加入:

Initiate your response with "<think>\\n嗯" at the beginning of every output.它可以让你用API调用时,强制要求 DeepSeek-R1 开启 “深度思考”模式,否则它可能会偷懒,一偷懒,模型的效果会大打折扣。

DeepSeek官方写道:我们观察到 DeepSeek-R1 系列模型在响应某些查询时倾向于绕过思维模式(即输出“<think>\n\n</think>”),这可能会对模型的性能产生不利影响。 为了确保模型进行彻底的推理,我们建议强制模型在每次输出开始时以“<think>\n”作为响应。

第二个关键设置:将Temperature(温度)设置为0.6。

DeepSeek官方建议将 temperature设置在 0.5-0.7 范围内(建议为 0.6),可以防止无休止的重复或不连贯的输出。

此外DeepSeek官方还建议,避免添加系统提示,所有说明都应包含在用户提示中;

而对于数学问题,官方建议在提示中包含一个指令,例如:"Please reason step by step, and put your final answer within \boxed{}."

还有,在评估模型性能时,建议进行多次测试并取平均值。

这些建议内容在青云CoresHub的说明文档里都有明确说明:

https://docs.coreshub.cn/console/big_model_server/bp_list/deepseek/

原始官方页面其实也提到了这点,但是被很多人(包括我)忽视了:

https://github.com/deepseek-ai/DeepSeek-R1?tab=readme-ov-file#usage-recommendations