想象一下,你让ChatGPT解一道小学数学题,它却像写博士论文一样列了20步推导——这就是当前大模型的“土豪式烧脑”。最近arxiv的一篇来自港中文的高效reasoning的survey,非常不错,从新颖的解读来整理的,推荐推荐~

论文:Harnessing the Reasoning Economy A Survey of Efficient Reasoning for Large Language Models链接:https://arxiv.org/pdf/2503.24377仓库:https://github.com/DevoAllen/Awesome-Reasoning-Economy-Papers

论文提出推理经济概念,核心目标就一句话:用最少的计算量,干最多的聪明事。就像手机开省电模式,既要流畅刷视频,又不能狂掉电。

核心矛盾:能力越强,越“烧脑”?

核心矛盾:能力越强,越“烧脑”?大模型有两种思维模式:

System 1(快思考):直觉反应,秒回答案但容易翻车System 2(慢思考):深度推理,准确但耗时长(比如GPT-4解数学题要生成几百字推导)矛盾在于:复杂任务需要System 2,但简单问题用System 2纯属“杀鸡用牛刀”。比如问“1+1=?”,模型可能先假设“用户是不是在考二进制”,然后列出一堆冗余步骤。

问题诊断:大模型的“无效内耗”从哪来?

问题诊断:大模型的“无效内耗”从哪来?论文揪出三大“电老虎”:

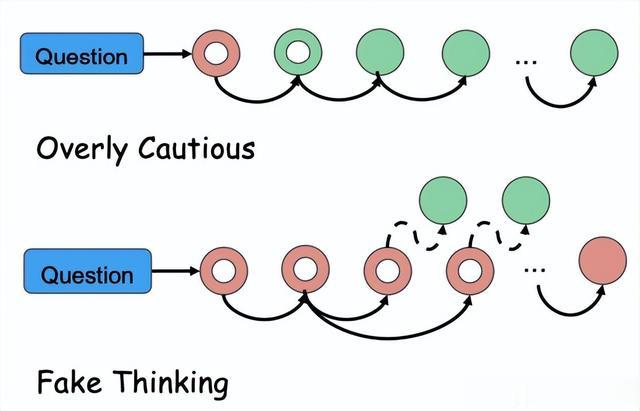

① 过度谨慎(Overly Cautious)

模型像强迫症患者,明明已得出正确答案,还要反复检查:“2+3=5?等等,我再算一遍...再再算一遍...”

② 假思考(Fake Thinking)

表面在推理,实际在划水。比如生成一堆“首先,这个问题很重要;其次,我们需要仔细分析...”的废话文学。

③ 资源错配

“简单题狂刷存在感,难题反而草草了事”。好比考试时花半小时解选择题,最后大题只剩5分钟。

解决方案:给大模型装上“智能刹车”训练阶段的“瘦身术”

数据精选:只喂“高蛋白”推理数据(如1000条优质样本抵10万条废话)奖励机制改革:给简短有效答案发“奖金”,对冗长回答扣“绩效”知识蒸馏:把教授级大模型的能力“压缩”成学生版,推理速度翻倍

数据精选:只喂“高蛋白”推理数据(如1000条优质样本抵10万条废话)奖励机制改革:给简短有效答案发“奖金”,对冗长回答扣“绩效”知识蒸馏:把教授级大模型的能力“压缩”成学生版,推理速度翻倍推理时的“动态油门”

预算预测:先判断题目难度,再分配计算资源(类似导航预估油耗)早停机制:检测到答案稳定立刻收工(比如连续5个回答一致就停)搜索剪枝:像AlphaGo放弃烂棋一样,及时砍掉低质量推理路径未来展望:推理经济将如何改变AI应用?手机端AI助理:7B小模型也能玩转复杂推理,告别云端高延迟自动驾驶决策:紧急刹车用System 1闪电响应,路径规划用System 2深度计算多模态革命:看图说话时自动跳过无关细节,直接输出关键结论

预算预测:先判断题目难度,再分配计算资源(类似导航预估油耗)早停机制:检测到答案稳定立刻收工(比如连续5个回答一致就停)搜索剪枝:像AlphaGo放弃烂棋一样,及时砍掉低质量推理路径未来展望:推理经济将如何改变AI应用?手机端AI助理:7B小模型也能玩转复杂推理,告别云端高延迟自动驾驶决策:紧急刹车用System 1闪电响应,路径规划用System 2深度计算多模态革命:看图说话时自动跳过无关细节,直接输出关键结论论文最后呼吁:让AI学会“该省省该花花”,才是可持续发展的王道。