HBM内存技术全面对比分析

- HBM,突破性3D内存技术,采用先进封装将多个DRAM芯片垂直堆叠,显著提升内存带宽,降低功耗。

- 实现大容量、高带宽存储,满足高性能计算、人工智能等领域对内存的严苛要求。

- 通过采用硅通孔(TSV)和微凸块等先进封装技术,HBM打破了传统内存带宽和功耗瓶颈。

- 与GPU集成封装,减少信号传输路径,降低延迟,进一步提升性能。作为基于3D堆栈工艺的高性能DRAM,打破内存带宽及功耗瓶颈。HBM(High Bandwidth Memory)即高带宽存储器,通过使用先进封装(如TSV硅通孔、微凸块)将多个DRAM芯片进行堆叠,并与GPU一同进行封装,形成大容量、高带宽的DDR组合阵列。

HBM技术通过与处理器相同的“Interposer”中间介质层与计算芯片实现紧凑连接,最大程度地节省芯片面积,同时大幅减少数据传输时间。

此外,HBM采用TSV工艺进行3D堆叠,有效提升带宽,降低功耗,实现更高的集成度。通过与处理器相同的“Interposer”中间介质层与计算芯片实现紧凑连接,一方面既节省了芯片面积,另一方面又显著减少了数据传输时间;此外HBM采用TSV工艺进行3D堆叠,不仅显著提升了带宽,同时降低了功耗,实现了更高的集成度。

HBM性能远超GDDR,是当前GPU存储单元的理想解决方案。相较GDDR,HBM拥有更快的速度、更高的带宽和更低的功耗。HBM可提供高达460GB/s的带宽,是GDDR的4倍多,同时功耗仅为GDDR的一半。HBM凭借其优越的性能,已成为当前GPU存储单元的理想选择,并被广泛应用于高性能计算、人工智能和图形处理等领域。性能远超GDDR,成为当前GPU存储单元理想解决方案。GPU显存一般采用GDDR或者HBM两种方案,但HBM性能远超GDDR。

HBM显存,更高带宽更强性能

HBM显存是GDDR5显存的升级版,在显存位宽、时钟频率和显存带宽上均有大幅提升。

显存位宽:HBM是GDDR5的4倍

HBM显存的位宽为1024-bit,是GDDR5显存的32-bit的4倍,这意味着HBM显存可以同时传输更多的数据。

时钟频率:HBM低于GDDR5

HBM显存的时钟频率为500MHz,低于GDDR5显存的1750MHz。但由于HBM显存的位宽是GDDR5显存的4倍,因此HBM显存的实际带宽远高于GDDR5显存。

显存带宽:HBM远高于GDDR5

HBM显存的一个stack的带宽大于100GB/s,而GDDR5显存的一颗芯片的带宽只有25GB/s。因此,HBM显存的数据传输速率远高于GDDR5显存。

总结:HBM显存是GDDR5显存的升级版,具有更高的带宽和更强的性能。AMD数据,从显存位宽来看,GDDR5为32-bit,HBM为其四倍,达到了1024-bit;从时钟频率来看,HBM为500MHz,远远小于GDDR5的1750MHz;从显存带宽来看,HBM的一个stack大于100GB/s,而GDDR5的一颗芯片才25GB/s,所以HBM的数据传输速率远远高于GDDR5。

HBM:高带宽、高容量、低功耗的GPU存储方案

HBM(High Bandwidth Memory)是一种高带宽、高容量、低功耗的GPU存储器技术。与传统GDDR5内存相比,HBM具有以下优势:

* 更小的芯片面积:HBM芯片面积仅为GDDR5芯片面积的三分之一,这使得HBM可以在更小的空间内实现更大的容量。

* 更高的带宽:HBM的带宽高达1TB/s,是GDDR5的8倍。这使得HBM能够满足高性能图形处理器的带宽需求。

* 更低的功耗:HBM的功耗仅为GDDR5的二分之一,这使得HBM在移动设备和笔记本电脑等功耗受限的环境中具有更广泛的应用前景。

因此,HBM被视为GPU存储单元的理想解决方案。目前,HBM已广泛应用于高性能图形处理器、人工智能加速器等领域。HBM由于与GPU封装在一块,从而大幅度减少了显卡PCB的空间,而GDDR5芯片面积为HBM芯片三倍,这意味着HBM能够在更小的空间内,实现更大的容量。因此,HBM可以在实现高带宽和高容量的同时节约芯片面积和功耗,被视为GPU存储单元理想解决方案。

- HBM 成为 AI 服务器搭载标配,满足海量算力需求。

- AI 大模型兴起催生海量算力需求,对芯片内存容量和传输带宽要求更高。

- HBM 3 提供高达 460GB/s 的传输带宽,是 GDDR6 的 3-4 倍,满足 AI 服务器高带宽需求。

- HBM 3 单颗容量最高可达 32GB,是 GDDR6 的 4-8 倍,满足 AI 服务器大容量内存需求。

- HBM 3 功耗更低,发热量更小,适合高密度 AI 服务器部署。GPU需求推动下,HBM目前已经成为AI服务器的搭载标配。AI大模型的兴起催生了海量算力需求,而数据处理量和传输速率大幅提升使得AI服务器对芯片内存容量和传输带宽提出更高要求。

HBM(高带宽内存)以其高带宽、高容量、低延时和低功耗的优势,成为AI服务器中GPU的搭载标配。英伟达推出的多款用于AI训练的芯片A100、H100和H200,均采用HBM显存:

- A100采用80GB HBM2显存,峰值带宽高达1.6TB/s。

- H100采用80GB HBM3显存,峰值带宽高达3.2TB/s。

- H200采用96GB HBM3显存,峰值带宽高达5.12TB/s。

HBM显存的应用,大幅提升了AI训练的速度和效率,是当前AI计算领域必不可少的重要技术。具备高带宽、高容量、低延时和低功耗优势,目前已逐步成为AI服务器中GPU的搭载标配。英伟达推出的多款用于AI训练的芯片A100、H100和H200,都采用了HBM显存。

优化后的文章:

- 英伟达最新的H200芯片采用更快的HBM3e显存,容量高达80GB。

- AMD的MI300系列也采用HBM3技术,MI300A容量为128GB,而MI300X容量为192GB,是H100容量的2.4倍。

- MI300X的容量相比前代提升50%,是H100容量的2.4倍,为业界提供更多内存选择。A100和H100芯片搭载了40GB的HBM2e和80GB的HBM3显存,最新的H200芯片搭载了速率更快、容量更高的HBM3e。AMD的MI300系列也都采用了HBM3技术,MI300A的容量与前一代相同为128GB,而更高端的MI300X则将容量提升至192GB,增长了50%,相当于H100容量的2.4倍。

HBM:高带宽存储技术的革命性进步

HBM(High Bandwidth Memory)技术稳步发展,掀起了一场存储技术革命。从2016年第一代HBM1诞生起,HBM已迭代至第五代——HBM3e。纵观五代HBM产品性能变化,可以发现其在带宽、I/O速率、容量、工艺节点等方面取得显著突破。

带宽:

- HBM1:128GB/s

- HBM3e:1TB/s

I/O速率:

- HBM1:1Gbps

- HBM3e:8Gbps

容量:

- HBM1:1GB

- HBM3e:最高36GB

工艺节点:

- HBM3e:5nm

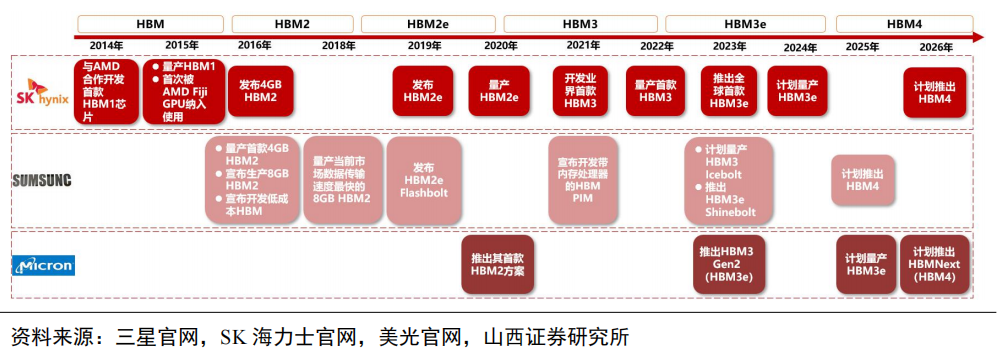

HBM技术不断革新,为高性能计算、人工智能、机器学习等领域提供了强有力的支持。未来,HBM技术有望继续突破极限,带来更快的速度、更大的容量和更低的功耗,推动新一代计算平台的构建。市场竞争激烈,HBM产品向低能耗、高带宽、高容量加速迭代。从2016年第一代HBM1发布开始,HBM目前已经迭代到第五代产品——HBM3e,纵观五代HBM产品性能变化,可以发现HBM在带宽、I/O速率、容量、工艺节点等方面取得较大突破,其中带宽由初代的128GB/s迭代至HBM3e的1TB/s,I/O速率由1Gbps迭代至8Gbps,容量从1GB增至最高36GB,制造工艺则取得进一步突破,达到5nm级别。

- HBM3e数据处理速度高达1.15TB/s,为AI技术提供强劲动力。

- HBM系列产品持续在低能耗、高带宽、高容量上发力。

- HBM系列产品的高性能将推动AI技术进一步创新和变革。HBM3e数据处理速度最高可达到1.15TB/s,HBM系列产品的更新迭代将在低能耗、高带宽、高容量上持续发力,以高性能牵引AI技术进一步革新。

HBM3e加持,AI芯片性能强势升级!

2023 年11月13日,英伟达发布了首款搭载最先进存储技术HBM3e的GPU芯片H200,带来显存容量和带宽的大幅提升。

与上一代产品H100相比,H200的显存容量提升76%,达141GB,显存带宽提升43%,高达4.8TB/s,为AI应用提供更强大的数据处理能力。

HBM3e的引入,标志着AI芯片性能的又一次飞跃,将为深度学习、图形渲染等领域带来更优异的表现。产品迭代助力AI芯片性能升级。当地时间2023年11月13日,英伟达发布了首款搭载最先进存储技术HBM3e的GPU芯片H200。H200作为首款搭载最先进存储技术HBM3e的GPU,拥有141GB显存容量和4.8TB/s显存带宽,与H100的80GB和3.35TB/s相比,显存容量增加76%,显存带宽增加43%。

重磅升级:英伟达H200 GPU再创AI大模型计算新高度!

凭借更大容量、更高带宽的显存,H200在人工智能大模型计算方面实现显著提升。

单卡性能傲视群雄:

- Llama2 130亿参数训练速度提升40%

- GPT-3 1750亿参数训练速度提升60%

- Llama2 700亿参数训练速度提升90%

能耗与成本双双下降:

- TCO(总拥有成本)最高可降低一半

- 能耗降低一半

H200以更优价格提供更强性能,更低能耗,成为AI大模型计算领域的领跑者。GPU核心未升级,但H200凭借更大容量、更高带宽的显存,依旧在人工智能大模型计算方面实现显著提升。根据英伟达官方数据,在单卡性能方面,H200相比H100,在Llama2的130亿参数训练中速度提升40%,在GPT-3的1750亿参数训练中提升60%,在Llama2的700亿参数训练中提升90%;在降低能耗、减少成本方面,H200的TCO(总拥有成本)达到了新水平,最高可降低一半的能耗。

HBM市场格局及发展趋势

- 目前由海力士、三星、美光三大原厂主导,海力士份额领先,占比50%。

- 2023年,生成式AI市场爆发式增长,驱动对HBM的需求激增。

- 高带宽、高容量的HBM成为AI服务器关键组件,尤其适用于大模型训练与推理。市场目前被三大原厂占据,其中海力士份额领先,占据HBM市场主导地位。据TrendForce数据,三大原厂海力士、三星、美光2022年HBM市占率分别为50%、40%、10%。2023年年初至今,生成式AI市场呈爆发式增长,大模型参数量、预训练数据量攀升,驱动AI服务器对高带宽、高容量的HBM需求迅速增加。

海力士:HBM3量产引领AIGC行业

作为HBM芯片的先驱,海力士在AIGC行业迅速发展之际,率先实现HBM3量产,抢占市场先机。2023年下半年,英伟达高性能GPU H100与AMD MI300将搭载海力士生产的HBM3,进一步巩固其市场领先地位。预计2023年,海力士、三星和美光在HBM市场上的份额分别约为53%、38%和9%。HBM芯片的海力士,在AIGC行业迅速发展背景下得以抢占先机,率先实现HBM3量产,抢占市场份额。2023年下半年英伟达高性能GPUH100与AMD MI300将搭载海力士生产的HBM3,海力士市占率将进一步提升,预计2023年海力士、三星、美光市占率分别为53%、38%、9%。

TSV技术,又称硅通孔技术,是一种先进的封装技术,通过在芯片与芯片、晶圆与晶圆之间垂直堆叠,实现硅通孔的电气互联。TSV技术具有显著提升存储容量、带宽并降低功耗的优势。它通过垂直堆叠多个DRAM芯片,在有限空间内大幅提升存储容量;同时,TSV技术可缩短芯片之间的信号传输路径,降低功耗,提高带宽。

TSV技术的应用已扩展至多种领域,包括高性能计算、移动设备和汽车电子等。随着技术的发展,TSV技术有望在更多领域发挥重要作用,成为推动电子设备向更小、更轻、更快的方向发展的关键技术。技术通过垂直堆叠多个DRAM,能显著提升存储容量、带宽并降低功耗。TSV(硅通孔)技术通过在芯片与芯片之间、晶圆和晶圆之间制作垂直导通,并通过铜、钨、多晶硅等导电物质的填充,实现硅通孔的垂直电气互联。

TSV 先进封装技术引领半导体器件微型化

TSV 先进封装技术作为实现 3D 先进封装的关键技术之一,能够提供更高的互连密度和更短的数据传输路径,从而提升芯片性能和传输速度。在摩尔定律放缓,芯片特征尺寸逼近物理极限的当下,半导体器件的微型化愈发依赖于集成 TSV 的先进封装。

目前,DRAM 行业中,3D-TSV DRAM 和 HBM 已成功生产 TSV,突破了容量和带宽的限制。TSV 先进封装技术的应用,为半导体器件的微型化和性能提升提供了新的途径,具有广阔的应用前景。3D先进封装的关键技术之一,对比wire bond叠层封装,TSV可以提供更高的互连密度和更短的数据传输路径,因此具有更高的性能和传输速度。随着摩尔定律放缓,芯片特征尺寸接近物理极限,半导体器件的微型化也越来越依赖于集成TSV的先进封装。目前DRAM行业中,3D-TSVDRAM和HBM已经成功生产TSV,克服了容量和带宽的限制。

TSV:HBM封装核心技术,成本占比高

TSV作为HBM核心工艺,在HBM3D封装成本中占比约30%。与传统POP封装相比,3D TSV工艺可节省35%的封装尺寸,降低50%的功耗,并带来8倍的带宽提升。

TSV成本分析:形成和显露占比

以4层存储芯片和一层逻辑裸芯进行3D堆叠的成本为例,TSV形成和显露的成本合计占比分别为30%和28%,超过了前/后道工艺的成本占比。这表明TSV是HBM3D封装中成本占比最高的部分。为HBM核心工艺,在HBM3D封装成本中占比约30%。根据SAMSUNG,3D TSV工艺较传统POP封装形式节省了35%的封装尺寸,降低了50%的功耗,并且对比带来了8倍的带宽提升。对4层存储芯片和一层逻辑裸芯进行3D堆叠的成本进行分析,TSV形成和显露的成本合计占比,对应99.5%和99%两种键合良率的情形分别为30%和28%,超过了前/后道工艺的成本占比,是HBM3D封装中成本占比最高的部分。

TSV技术工艺流程

- 深孔刻蚀:使用深反应离子刻蚀 (DRIE) 法制作通孔。

- 沉积:使用化学气相沉积 (PECVD) 方法沉积介电层,使用物理气相沉积 (PVD) 方法沉积阻挡层和种子层。

- 电镀铜:选择电镀铜 (Cu) 进行填孔。

- 减薄抛光:使用化学和机械抛光 (CMP) 法去除多余的铜。

- 晶圆减薄和键合:完成铜填充后,需要进行晶圆减薄和键合。技术主要涉及深孔刻蚀、沉积、减薄抛光等关键工艺。TSV首先利用深反应离子刻蚀(DRIE)法制作通孔;然后使用化学气相沉积(PECVD)的方法沉积制作介电层、使用物理气相沉积(PVD)的方法沉积制作阻挡层和种子层;再选择电镀铜(Cu)进行填孔;最后使用化学和机械抛光(CMP)法去除多余的铜。另外,由于芯片堆叠集成的需要,在完成铜填充后,还需要晶圆减薄和键合。

HBM多层堆叠结构推动封装设备需求增长

前道环节:

- TSV垂直方向连接增加TSV刻蚀设备需求。

- HBM工艺增加TSV、微凸点、硅中介层等工序,带动前道检、量测设备需求增长。

后道环节:

- HBM堆叠结构增多,要求晶圆厚度不断降低,对减薄、键合设备需求提升。

- 超薄晶圆和铜铜混合键合工艺增加临时键合/解键合等设备需求。

- 各层DRAM Die的保护材料要求提高,对注塑或压塑设备提出更高要求。

综上,HBM多层堆叠结构提升工序步骤,带动封装设备需求持续提升。多层堆叠结构提升工序步骤,带动封装设备需求持续提升。(1)前道环节:HBM需要通过TSV进行垂直方向连接,增加了TSV刻蚀设备需求,同时HBM中TSV、微凸点、硅中介层等工艺大量增加了前道工序,给前道检、量测设备带来增量;(2)后道环节:HBM堆叠结构增多,要求晶圆厚度不断降低,这意味着对减薄、键合等设备的需求提升;HBM多层堆叠结构依靠超薄晶圆和铜铜混合键合工艺增加了对临时键合/解键合等设备的需求;(3)各层DRAM Die的保护材料也非常关键,对注塑或压塑设备提出了较高要求。

-对此,您有什么看法见解?-

-欢迎在评论区留言探讨和分享。-