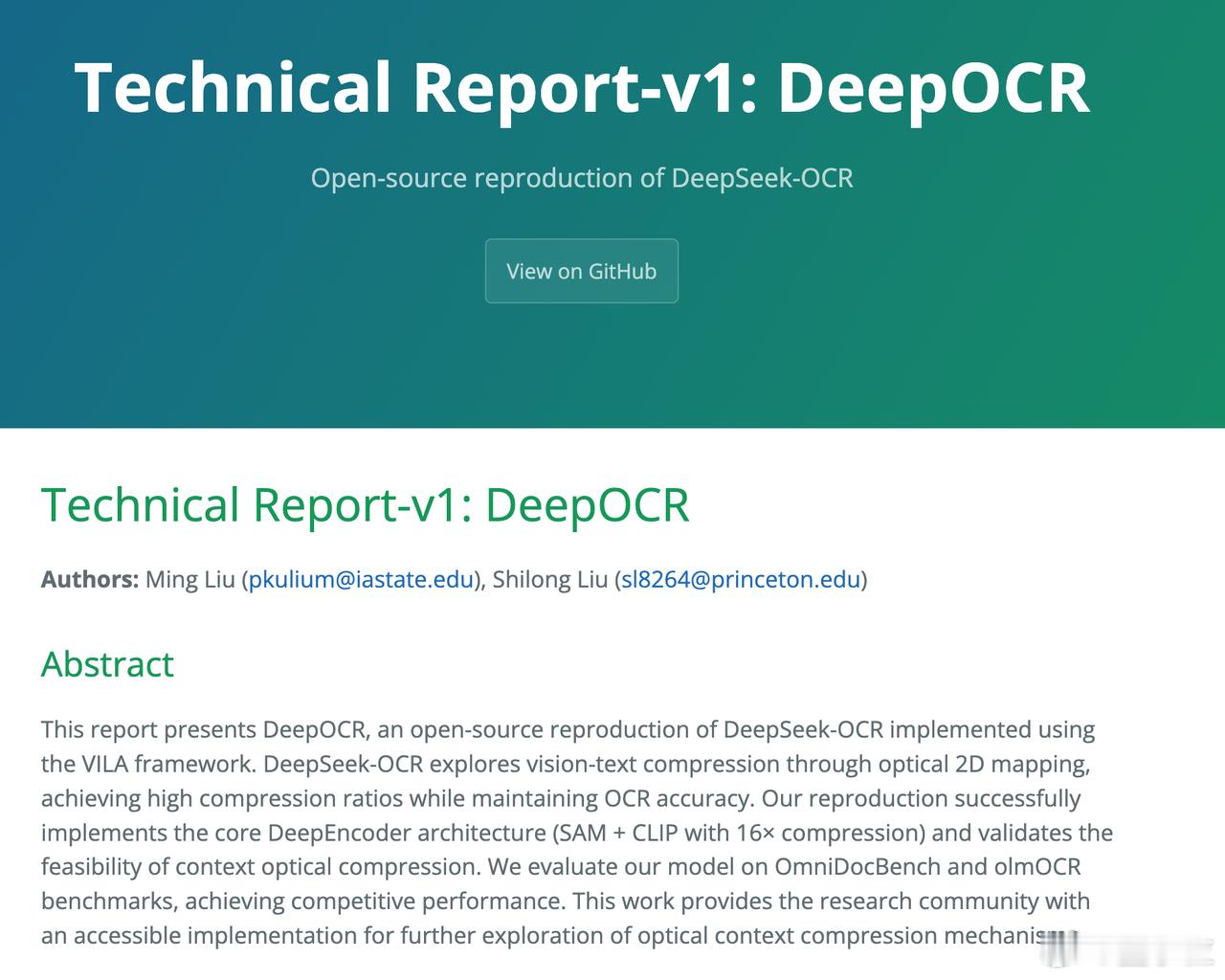

我肤浅了,DeepSeek OCR 目前引起了广泛的讨论。其根本原因不在于拥有了多模态中的视觉能力,而是 DeepSeek 训练出来了一个专精文本视觉内容的视觉语言模型。

他的确在处理非文字图像上不太行,这也是被低调的命名为 OCR 的原因吧。

但是,这个开源模型很小,3B ,这很接近前两天我转发的前 Open AI 员工访谈中说的,拥有人类核心知识的模型可能只需要 1B 。

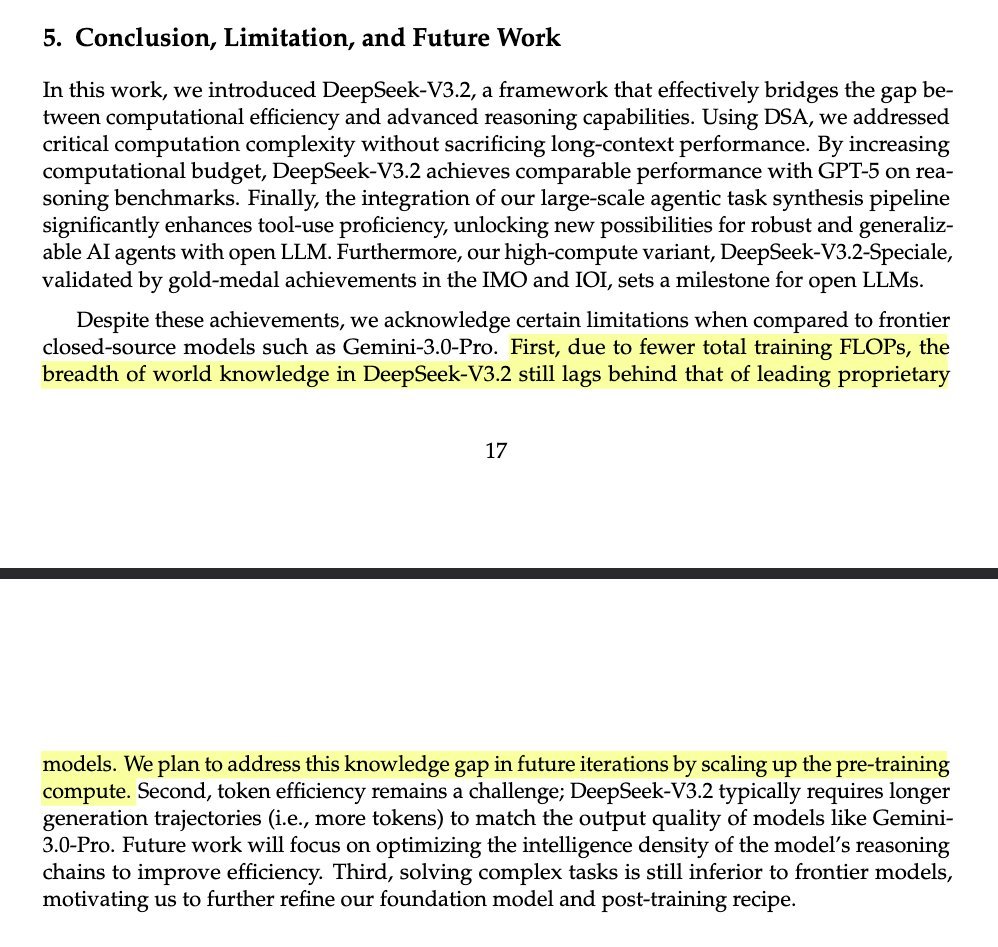

而且,这个模型的运行成本非常低,效果媲美主流商业模型。这得益于上下文压缩机制的创新以及训练范式的差异。

也就是说,这是一个很小的,高效的,但是可以像人一样看文档的模型。他会关注文档的布局,字体,其中的表格等等元素,同时也能处理弯曲排版或者手写字体。

今天我们已经用软件发展了比较强大的 OCR 能力,为何需要一个 OCR 模型呢?

1

拥有视觉和自然语言理解能力的 DeepSeek OCR 的能力会比扫描软件更强大。

训练完成后,出现新的字体,或者排版比以往混乱,并不会导致他识别不了视觉内容。

2

DeepSeek OCR 本身是开源的。所以他可以轻易的被整合到任何 MoE 大模型中。

这样模型之间的交流可以用比人类的自然语言更高效的方式,token 序列或嵌入向量(embeddings)。我估计这也是 DeepSeek OCR 本来的设计用途。

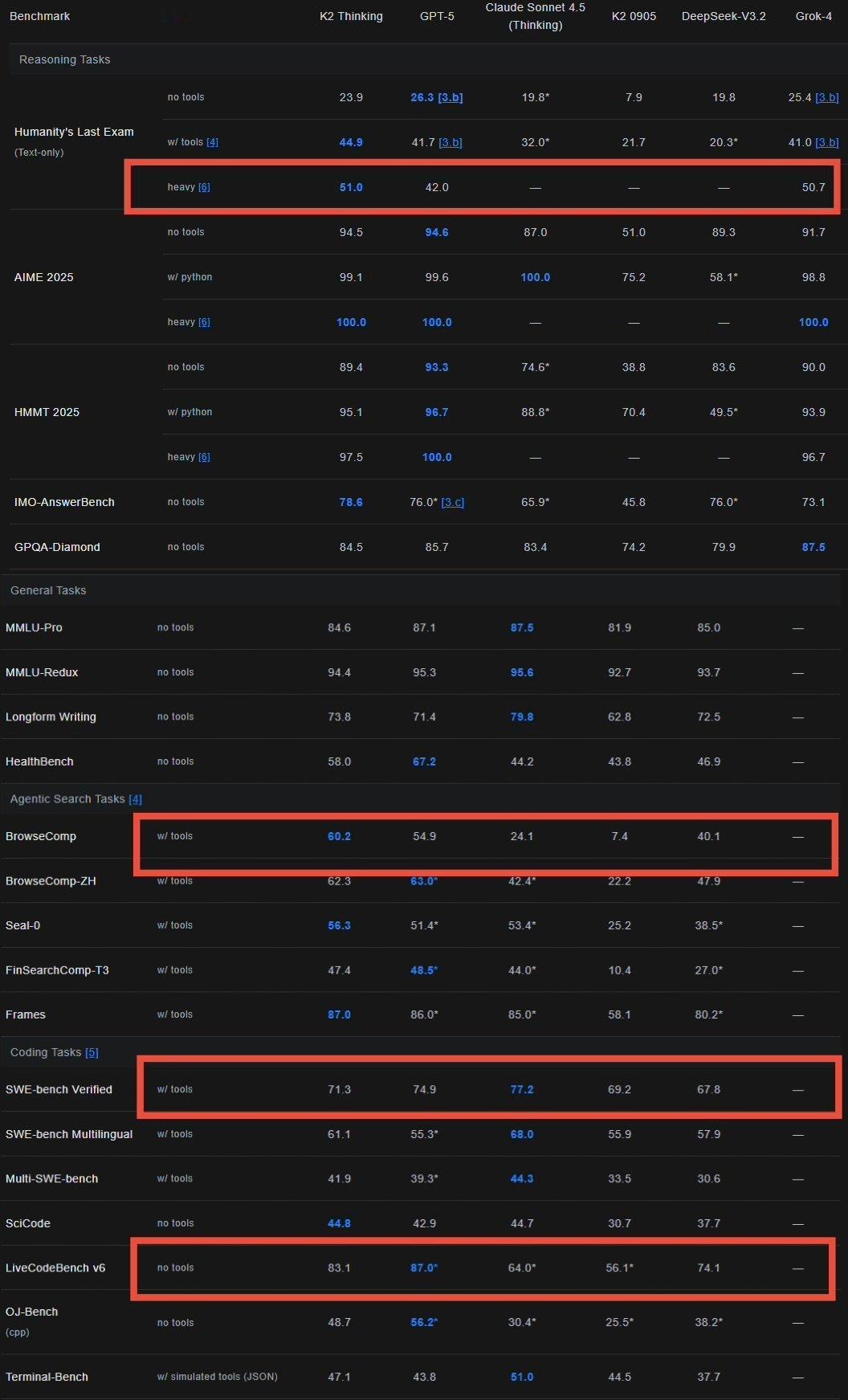

简而言之,DeepSeek 再一次在视觉上挑战了规模法则,并且成功了。

而且,再次用 MoE 模式增加了一个实用的高效模型,并且可以整合到全球所有开源模型(甚至包括商业模型都可能使用)。

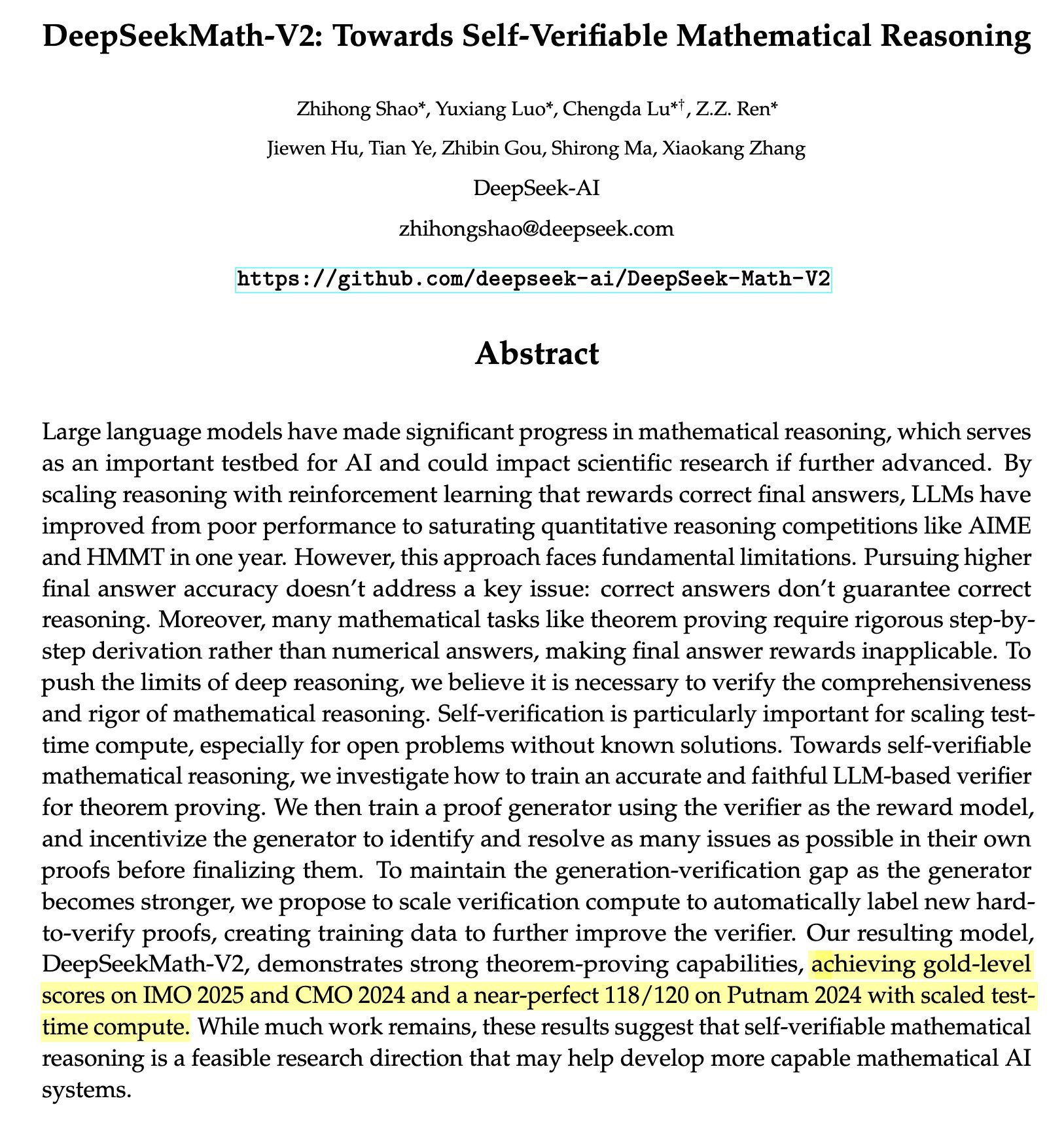

模型的能力突破,真的未必是天量数据,天量算力的暴力训练了。

当人类越来越了解模型,并且数据越来越准确精细,我们是有能力训练出一系列能力非常强,成本非常低的专业模型,并且通过他们的协作,最终更好的解决通用问题的。

再简而言之,

会越来越像人类的公司。