哈喽小伙伴们好,我是Stark-C~

我记得之前我分享了一次在我的华硕AS6704T NAS上玩本地大模型Ollama的时候虽说部署成功,但是因为NAS的性能毕竟有限,最后的体验可以说是非常的难受,最主要的是NAS跑起来也是非常的吃力,处理器几乎一直满载运行,温度也是迅速飙升,大有爆炸之势...

如是我看到了桌前的极空间Z423旗舰版,搭载了AMD 锐龙7 5825U处理器,8核16线程,最高频率可达4.5Ghz;内置AMD Radeon Graphics(VEGA 7)核显,2.0GHz核显主频,8个执行单元,且还标配了32GB的内存,整体配置都达到了性能主机的标准,可以说是目前家用旗舰NAS的天花板。

然后我在想,如果在极空间Z423旗舰版跑Ollama大模型,效果是不是会好一些呢(换句话说,炸起来的样子会不会更帅些?)。

反正都是折腾,先盘起来再说!

部署和之前的部署方案一样,咱们此次部署也是需要两个项目的支持:

Ollama:这个就不用说了,Ollama大型语言模型的主程序,专门用于部署和本地运行开源大型语言模型,比如今天要说的Llama 3模型。Open WebUI:这个是一个开源的 Web 用户界面工具,为用户提供了友好的可视化界面来与 Ollama 平台进行对接和交互。

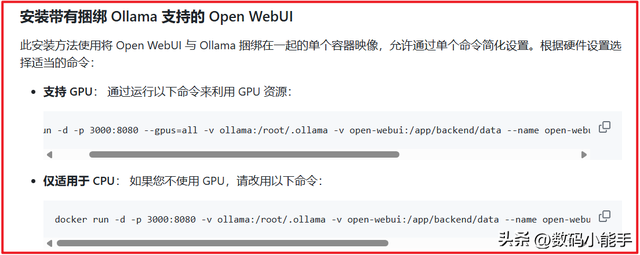

不过相比上次华硕NAS部署还需要两个Docker容器相比,此次我们就只需要一个Docker容器即可。因为官方推出了一个Open WebUI捆绑Ollama的镜像文件,部署起来就更简单了!

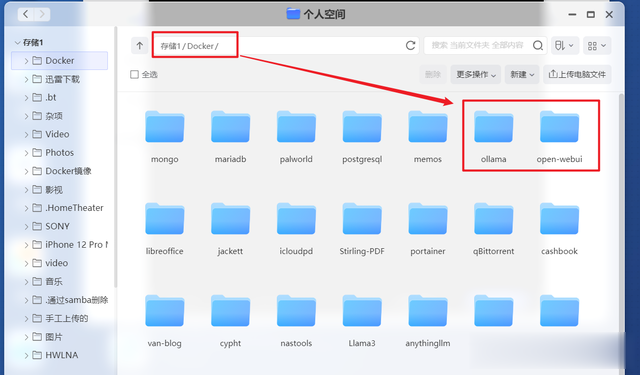

根据Docker Run命令,咱们需要提前建立两个数据存储的持久化映射目录,所以我们在极空间的Docker目录里分别新建两个文件夹:【ollama】【open-webui】

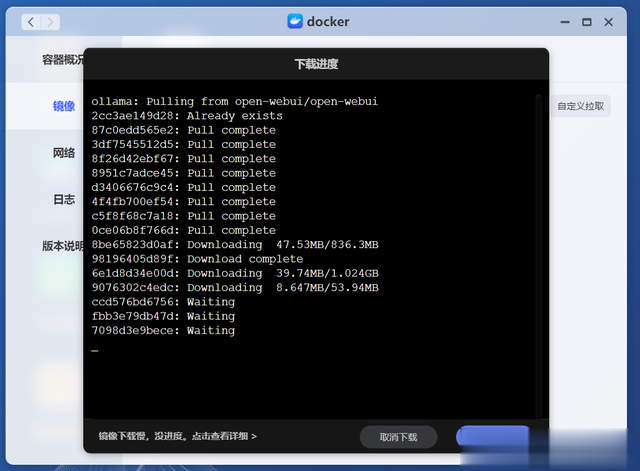

然后打开极空间Docker管理器的镜像仓库,自定义拉取镜像“ghcr.io/open-webui/open-webui:ollama”。

因为是两个镜像合并,所以总容量有些大,咱们可能需要多等待一点时间。

PS:别问我为什么镜像拉取不受影响,我只能说“网是折腾的基础,有网走遍天下”。

等待镜像下载完毕双击镜像开始部署容器。

显示“基本设置”这里,因为跑Ollama大模型还是非常占用资源的,所以我们这里需要取消勾选“启用性能限制”,同时前面在介绍Z423的配置我说过,它搭载的AMD 锐龙7 5825U处理器以及核显性能都不错,而Ollama大模型恰好也支持CPU与GPU两种运行模式,所以我们这里可以勾选“调用核心显卡”看看它的表现如何(稍后我也会不勾选看看有什么区别~)。

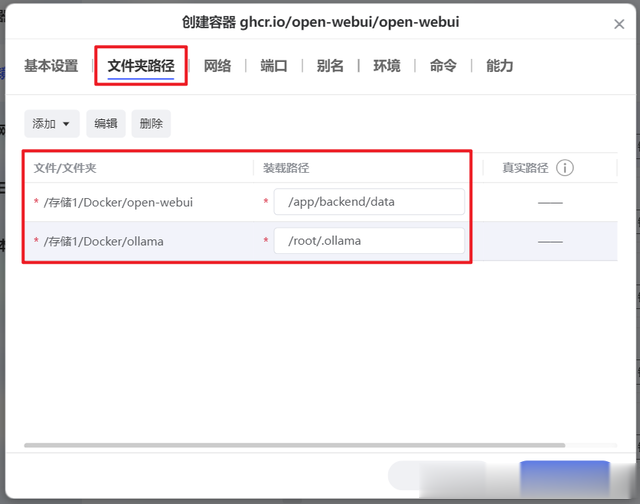

文件路径就按我们前面新建的两个文件夹,添加以下两个映射:

open-webui:/app/backend/dataollama:/root/.ollama

最后是“端口”,本地端口设置任意没被占用的即可。其它的就没什么好更改的了,直接点“应用”完成容器部署。

回到极空间Docker管理器的容器列表等待容器启动,需要等待大概10秒钟的样子,当看到容器前面显示“正常”,就说明可以使用了。

体验

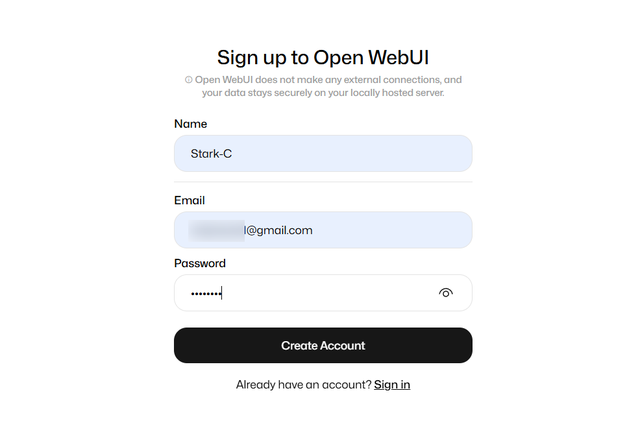

部署成功后我们就可以打开Open WebUI容器的WEB页面,也就是浏览器【http:// NAS的局域网IP:端口号】 。首次进入需要点击“Sign up”注册一个账号。

注册很简单,就随意设置名称、邮箱、密码三项即可。

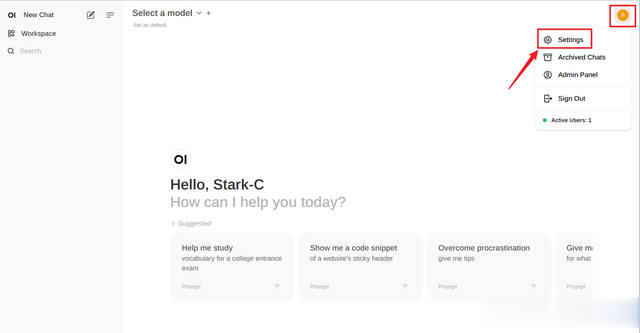

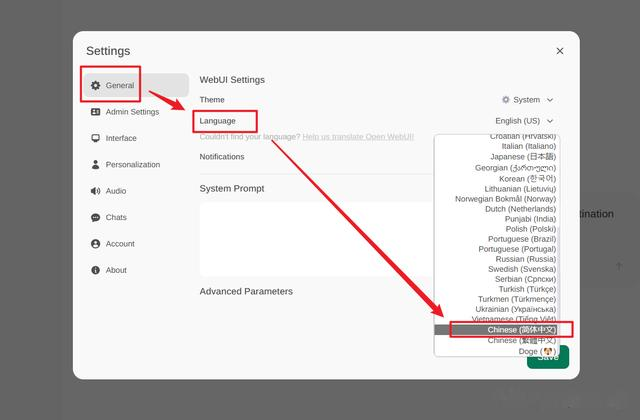

进入Open WebUI后台它默认还是英文主页面,好在它是原生支持中文的,点击右上角的“设置”。

根据上图提示设置成简体中文并保存。

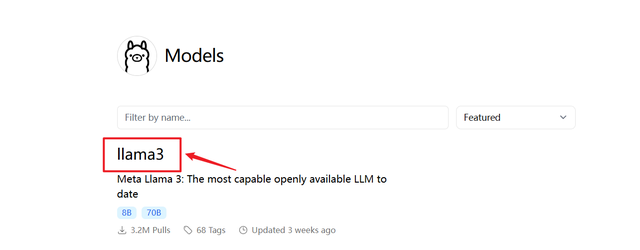

接着添加Llama 3大语言模型,也是在“设置”页面,选择“模型”。它会提示让你拉取一个模型,但前提是我们需要知道模型的名称。如果你不清楚可以点它给出的提示“点击这里”。

然后会重新打开另一个新的页面,第一个便是Llama 3。

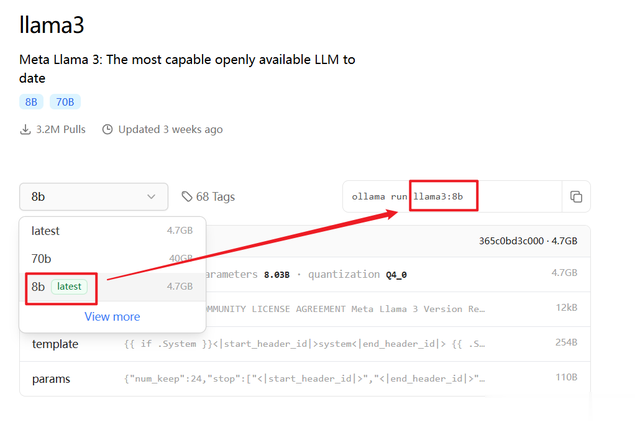

进入Llama 3页面会有版本选择,以及对应的模型容量大小。我选择了容量相对小一点的“8b”,然后它对应的名称就是上图方框所示的“llama 3:8b”,我们将这个名称复制下来。

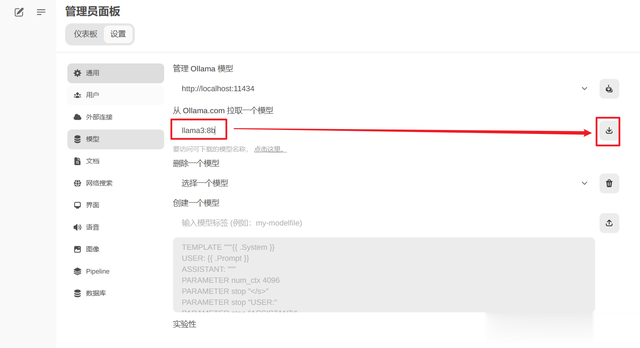

粘贴到Open WebUI“设置”页面的模型这里,点“下载”图标。

它就会将模型下载到本地了,并且在下方会有一个下载的进度条显示。因为llama 3:8b模型较大,所以下载的时候可能会比较长,咱们耐心等待便是。我这里不知道是不是个例,中途页面假死了两次,我是刷新进又重新拉取,好在它支持续传,并没有耽误之前的下载。

下载成功之后会弹出提示。

然后回到Open WebUI主页,在顶部位置选中我们下载好的llama 3:8b模型就可以直接使用了。

我尝试问了两个问题,等待了差不多10秒钟它便开始出答案,并且出答案的速度差不多每秒5--8个字,虽说谈不上快,但是已经属于能接受的那种水平,比之前一个字一个字的蹦出了强多了。

我在它回答问题的时候打开极空间的设备监控,可以看到当前资源确实被Ollama模型占用,不过CPU占用为48%(之前华硕NAS的N5105处理器直接99%),内存占用15%,区别还是挺大的。

我尝试不调用核心显卡(停止容器重新编辑)。

然后也是在它回答问题的时候打开极空间的设备监控,可以看到处理器占用稍微提高到55%,内存占用依然为15%,和之前的区别貌似不大(并不排除我可能并没有成功启用GPU来跑这个模型)。

最后不得不说,极空间Z423旗舰版作为目前私有云NAS的天花板,拥有强大的硬件性能输出,带来的一些体验还是很多其它同类产品所不能匹敌的,所以说如果你对NAS有性能方面的需求,或者和我一样是个极致的折腾爱好者,那么极空间Z423旗舰版可能就是你需要的。

好了,以上就是今天给大家分享的内容,我是爱分享的Stark-C,如果今天的内容对你有帮助请记得收藏,顺便点点关注,我会经常给大家分享各类有意思的软件和免费干货,咱们下期再见!谢谢大家~