你有没有在看电影的时候,突然觉得自己被角色的一言一行打动了?

有人说,这是电影的魔力;但你有没有想过,这其实是情感识别的力量?

最近,阿里巴巴推出了一个新的开源项目——R1-Omni,它首次结合了全模态情感识别。

这项技术究竟有什么特别之处呢?

今天我们就来聊聊这个新鲜出炉的研究成果。

DeepSeek与RLVR的结合:从图像到全模态的进化在过去,情感识别技术主要集中于图像和文本多模态的处理。

什么是多模态?

简单来说,就是同时处理两种或更多的数据类型,像图像、文本、音频等。

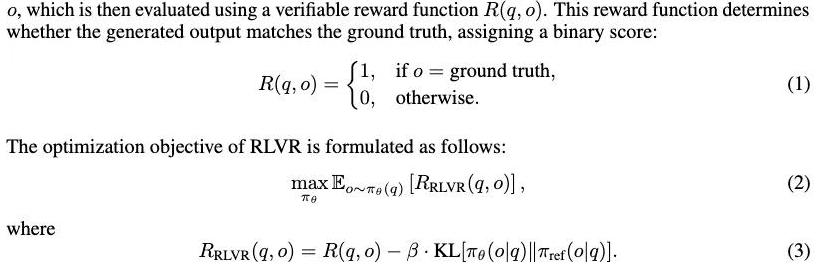

而DeepSeek带火的RLVR(一种验证奖励强化学习)曾经就用于图像和文本的情感识别中,结果非常优秀。

可是,一直到阿里R1-Omni出现,才有人尝试把这项技术运用到全模态情感识别中,包括音频和动态视觉。

想象一下,我们在和朋友聊天,他们的言语、表情、语调,都在传达情感。

这三种信息的结合,构成了完整的交流体验。

而在机器学习领域,把这些模态汇集到一个系统里,是一件极具挑战性的事。

但是,阿里巴巴的这个新项目,正是首次尝试了这个全新的方向。

R1-Omni模型的优势:推理、理解、泛化的全面提升你可能会问,R1-Omni到底有什么特别之处呢?

简单说来,它在推理、理解和泛化能力上,都超越了以前的多模态情感识别模型。

推理能力更强。

R1-Omni可以更好地分析情感识别过程中不同模态(比如视觉和音频)的作用,并且合理地得出最终结论。

理解能力进一步提升了。

情感识别不仅仅是表面上的图像和文本匹配,更重要的是背后的情感推理。

R1-Omni在这方面做得相当不错,它不仅能识别情感,还能解释为什么会得出这样的结论。

这对于需要高可解释性的应用场景,像是医疗和法律领域,具有非常重要的意义。

最关键的是它的泛化能力。

也就是说,当面对不曾见过的情景时,R1-Omni依然能表现出色。

不仅能应对各种分布内数据,还对分布外的数据依旧保持高水平的性能。

你可能会问,这到底有什么用呢?

想象一下,我们通过不同的电影场景训练了一个情感识别模型,这个模型在一个全新的电影类型里,依然能准确识别主角的情感,这就是泛化能力的体现。

动手实验:在EMER和人造数据集上的微调与优化阿里的团队为了确保R1-Omni的性能,进行了大量的实验。

他们在两个数据集上进行了微调和优化,一个是包含情感推理数据的EMER数据集,另一个是手动标注的HumanOmni数据集。

这些数据集帮助模型获得了初步推理能力,识别哪些视觉和音频线索对于情感识别至关重要。

再通过一种叫做RLVR的强化学习方式进行训练,优化模型使其能更好地匹配真实情感。

并确保输出符合指定的格式,这样的设计让模型在实际应用中更加可靠和易用。

大家可能会觉得这些听起来很学术,但背后的逻辑其实很简单:通过大量真实世界的数据,反复训练和优化模型,最终目的是让这个技术在我们生活中的各个方面发挥作用,不管是娱乐、医疗还是智能客服。

全模态情感识别的实际应用前景想象一下,一个这样的系统在未来能带来什么样的变化。

首先是市场营销和广告行业。

通过分析观众的情感倾向,广告商可以精准推送更能引起共鸣的广告内容。

这不仅能大大提高广告的效果,还能让消费者感觉广告更贴近自己的需求和情感。

在人工智能客服方面,全模态情感识别能够让客服系统更智能、更人性化。

比如当你打电话投诉时,系统不仅能听出你的愤怒,还能通过你的语调和用词,进一步理解你到底在抱怨什么,从而提供更贴心的解决方案。

而在医疗领域,这样的技术能帮助医生更好地理解患者的情绪和心理状态。

特别是在心理咨询和精神病治疗中,情感识别技术可以辅助医生进行更精准的诊断和治疗。

结尾:通过R1-Omni的开发和应用,我们可以看到全模态情感识别技术的巨大潜力。

这不仅是技术上的突破,更是我们在理解和处理人类情感方面迈出的重要一步。

或许有一天,当我们与机器进行互动时,它们能像人类一样,真正理解我们的情感和需求,而这一切,可能都会从R1-Omni开始。

未来的世界,会因为这些技术变得更加智能和温暖。

这个故事不仅仅关于技术的进步,更关于我们如何通过科技,走进彼此的内心世界。

或许,这正是我们真正需要的,那些能够打动人心的情感连接。