一、为什么需要模型压缩?

一、为什么需要模型压缩?AI大模型(如ChatGPT、GPT-4)虽然功能强大,但存在明显缺点:

1. 体积庞大:参数动辄数十亿甚至千亿级,占用大量存储空间;

2. 计算资源消耗高:运行需要高性能GPU/服务器,成本高昂;

3. 部署困难:无法直接在手机、智能手表等小型设备上使用 。

模型压缩的目标是让大模型“减肥”,在保留核心能力的前提下,变得更轻、更快、更省资源。

二、发展历程:从简单到智能的压缩技术1. 早期阶段(2010年前):

通过简单的数学方法压缩参数,例如删除接近零的权重,但效果有限。

2. 深度学习兴起(2010-2018):

出现了剪枝(去掉不重要的神经元)和量化(降低参数精度),比如将32位浮点数改为8位整数。

3. 大模型时代(2018年后):

针对GPT、BERT等超大模型,发展出更复杂的技术,如知识蒸馏(让小模型模仿大模型)和低秩分解(拆分复杂矩阵)。

三、基本原理:如何给模型“减肥”?

核心思想是去除冗余信息,同时保留关键能力。

类比人类学习:学生不需要记住课本的每个字,只需掌握核心公式和案例。模型压缩类似,只保留对结果影响最大的参数。

四、核心技术:四大主流方法1. 剪枝(Pruning)

● 原理:像修剪树枝一样,删除模型中不重要的参数(例如权重接近零的神经元)。

● 效果:模型体积减少30%-90%,但准确率几乎不变。

● 例子:人脸识别模型删掉对背景敏感的神经元,专注面部特征。

2. 量化(Quantization)

● 原理:将参数精度从高精度(如32位)降低到低精度(如8位甚至1位)。

● 效果:存储空间减少4倍,计算速度提升2-4倍 6。

● 例子:手机拍照时,用低精度参数处理图像,依然清晰但更省电。

3. 知识蒸馏(Knowledge Distillation)

● 原理:让小型模型(学生)学习大模型(老师)的输出逻辑,而非直接复制参数。

● 效果:小模型能达到大模型90%以上的准确率,体积缩小数十倍。

● 例子:ChatGPT的简化版可在手机上运行,回答质量接近原版。

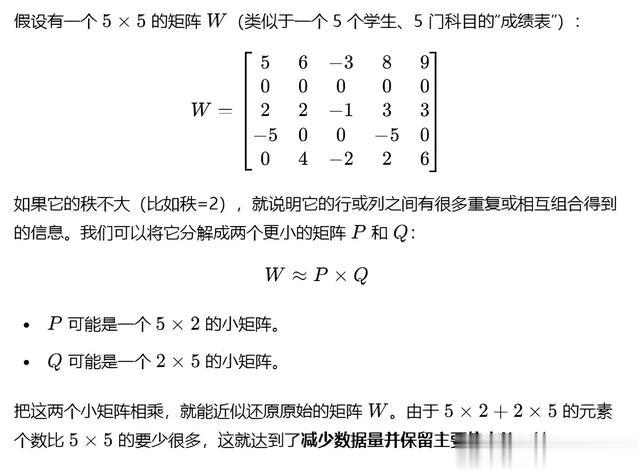

4. 低秩分解(Low-Rank Decomposition)

● 原理:将大型矩阵拆解为多个小型矩阵相乘,减少计算量。

● 例子:把1000×1000的矩阵拆成两个1000×10的矩阵,计算量降低到1/50。

五、应用场景与挑战

1. 应用场景:

● 手机APP(如语音助手、实时翻译);

● 自动驾驶(轻量化模型可在车载芯片运行);

● 物联网设备(如智能摄像头)。

2. 挑战:

● 压缩过度会导致模型“失忆”(性能大幅下降);

● 部分技术依赖人工调试,自动化程度待提升。

总结模型压缩是让AI大模型更亲民的关键技术,通过剪枝、量化等方法,在性能和效率之间找到平衡。未来随着算法优化,小设备也能运行“缩小版GPT”,推动AI无处不在。