随着人工智能技术的飞速发展,大模型在各行各业的应用越来越广泛。然而,如何将这些强大的模型与现有的业务系统完美对接a,成为了一个亟待解决的问题。大模型Plus伴侣-Lag[i],它将彻底改变这一局面。Lag[i]可以将这些强大的大模型与实际业务需求相结合,实现需求侧的稳、准、快,使得大模型能够更加稳定、准确且快速地服务于业务场景。

企业在大模型应用上普遍面临的问题是较高的AI技术门槛和算力门槛,因而中间件的出现就是在大模型研发厂商和企业之间构建一条跨越鸿沟的桥梁。它位于数据、操作系统和应用、人机交互方式之间,为彼此提供统一的接口协议和调度管理,以实现多个软硬件或模型、数据之间的的互操作性和资源共享。中间件可以简化应用软件的开发和部署过程,提高系统的可扩展性和可维护性。

Lag[i]中间件为了连接前端应用和后端的大模型,同时提供一系列的服务和功能,以便于实现AI应用的快速开发和部署。Lag[i]降低了大模型的集成难度,使得非AI专业人员也能轻松构建或升级现有的系统,以充分利用大模型带来的优势。这种优势不仅增强了系统的灵活性和可扩展性,还极大地提高了大模型在实际应用场景中的落地速度。

想象一下,后端错综复杂的异构大模型与前端多样化的应用之间,有了Lag[i]作为顺滑的桥梁。无论是检索增强的RAG框架,还是多模态对齐,甚至是公有与私有模型的智慧混搭,都可以丝滑接洽!虽然企业要落地知识库方案仍然有一些具体问题需要解决,如知识库的构建难度,AI应用的集成的效果和数据安全性的问题。那么现在大模型中间件Lag[i]将会是在大模型生态中起承转合的关键。

您可用Lag[i]为基础,快速开发您自己的大模型应用!第一步:安装配置向量数据库如图所示,以配置本地chroma向量数据库为例:

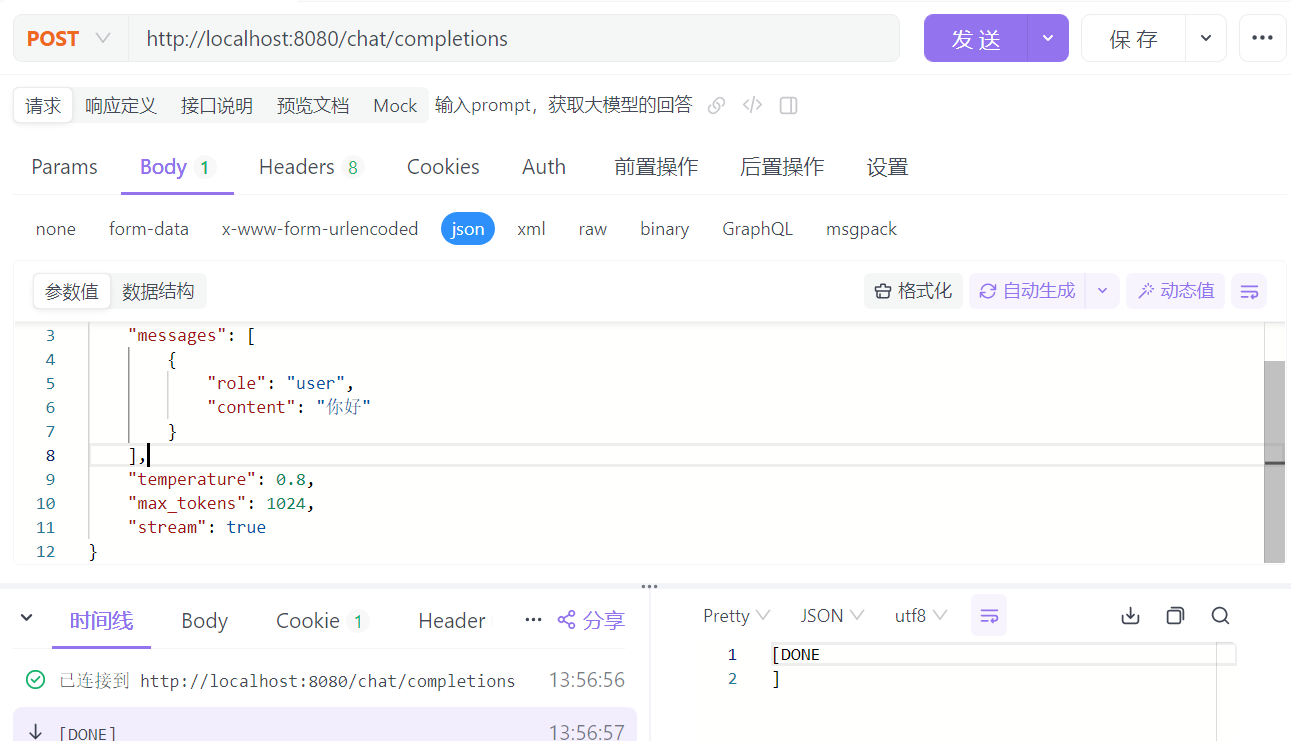

第二步:申请对应的key并启用该模型

如图所示,以配置智谱轻言的chatGLM为例:

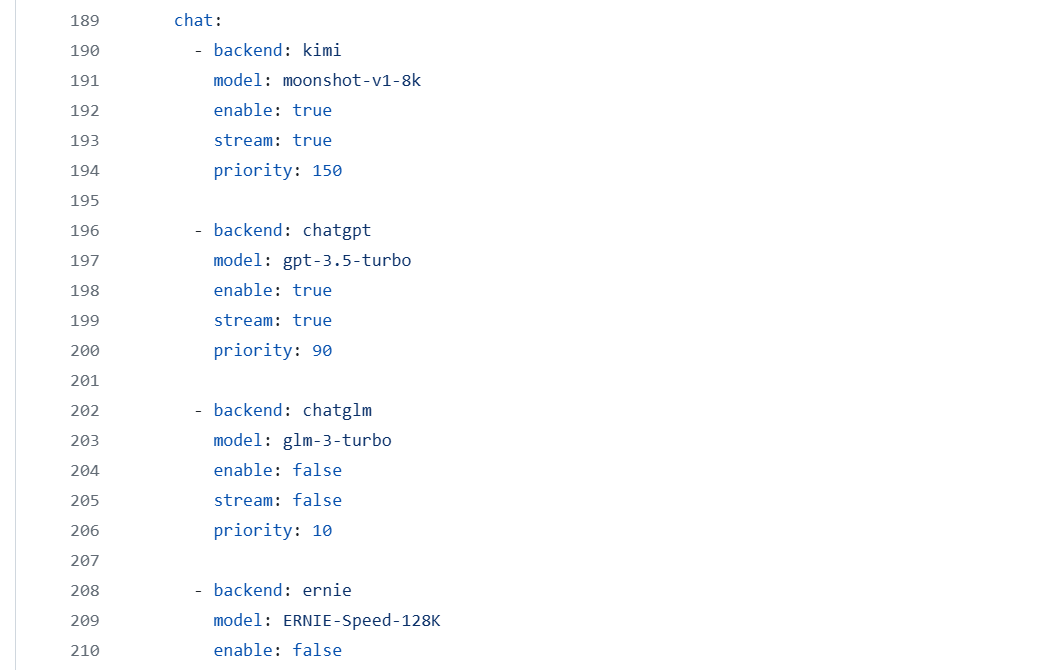

步骤三:启用该模型并设置优先级和输出形式如图所示,以kimi为最高优先级; 如优先级大模型不可用,Lag[i] 会根据priority数值和enable自动切换到其他备用模型,从而完成您的需求。

配置完成即可打开页面正常访问了!

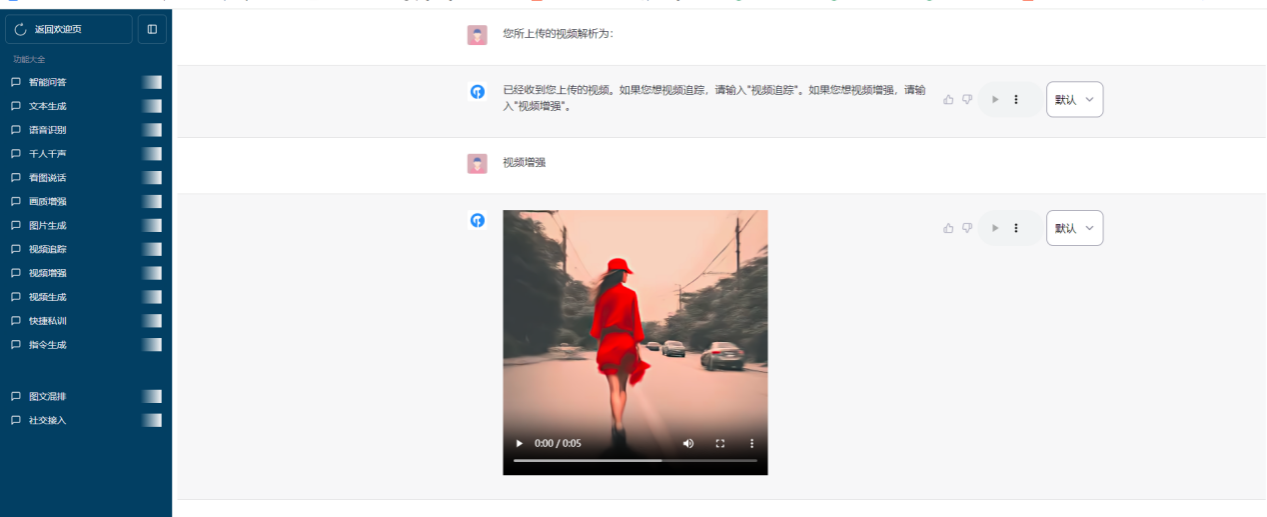

您还可以在线切换模型来完成您的需求:

切换后问答:

如果对Lag[i]已适配的大模型不满意,还可以对大模型进行扩展,创建属于您自己的大模型。通过修改配置文件设置需要过滤的关键词→设置优先回答的关键词→设置停止关键词等步骤,从而改变对话的返回结果,引导对话朝着特定的方向发展,并在需要时自动停止对话。

随着技术的不断演进,大模型中间件将更加智能化和自动化。未来的Lag[i]可能会集成更多的能力,能够在不断变化的数据环境中持续优化性能。

Lag[i]中间件的推出标志着我们在大模型应用领域迈出了重要的一步。通过Lag[i]我们将能够帮助更多企业加速数字化转型的步伐。未来,我们将继续努力,为用户提供更多、更好的工具和服务,共同迎接人工智能的新时代。

联动中间件项目已开源。

地址:

https://github.com/landingbj/lagi

世界不会在意你的自尊,人们看到的只是你的成就。在你没有成就以前,切勿过分强调自尊。

—菲茨杰拉德《了不起的盖茨比》