“恐怖谷”这个概念,出自于上世纪70年代,是由机器人专家森政弘提出来的。

他是这么形容的,“当机器人与人类的相似度达到某特定程度时,人类对其反应便会突然变得非常负面和反感。当机器人和人类的相似度继续上升,人类对其反应会再度回到正面。”

在自动驾驶这一赛道上,也有“恐怖谷”的说法。

当前的自动驾驶,奔涌向前,但宣传口和技术口并不匹配。具体点说,实际处于L2级的自动驾驶,已经具备了L3或L4的部分功能,但整个系统的能力又达不到。

在这种情况下,宣传口又非常容易“越界”,一波激进的操作,传递到用户那边,极容易被放大一些功能,却忽略一些风险。

但真正去用的时候,又觉得“不好用”,落差很大。“有点像人在开车,却又非常讨厌让它来开”,人会觉得不安全、不舒心,反而有惊吓。

这个过程可能有些漫长,我们又该如何度过呢?我们看到了走出“恐怖谷”的曙光吗?

最近几天,问界很火。一整个长假,听到最多的就是“遥遥领先”。

有一个最朴素的观察,原本以为“遥遥领先”四个字是“数码圈”和“汽车圈”的专属,但回老家才发现,“遥遥领先”已经入侵了爸妈的社交圈。

线上无孔不入,线下同样凶猛,问界M7截至本周一大定数预计有5.5万单,而到本周末,有可能冲击到6万单。

问界M7“起死回生”,有一个原因值得注意,华为的智能辅助驾驶系统悄然走红。

但走红的背后,不是因为它多么高阶,如何在城区智驾中大显身手,反而是因为锐化了“安全”这个词。

很多用户相信,华为智驾比人驾驶更安全,尤其是一些突发情况,比如走神了,这个车真有可能帮你紧急刹住。

安全,成为智驾的“超级符号”,其实有点诧异,因为这个需求很朴素,似乎与智驾前卫、科技的光环不相搭。

但又觉得恰在情理之中,因为智驾而选择一款车的理由可能靠后,但因为安全而选择一款车的理由就靠前了。

自动驾驶希望走出“恐怖谷”,让更多的用户欣然接受,并真正开始普及,或许,先不必谈接管次数、开放城市、雷达数量,将安全这个场景演绎能做好,大概就可以让不少用户乐于买单。

宣传的侧重点,俨然需要变一变了!

好消息是,在问界M7这款车上,确实有更多用户愿意选择智驾版本,这个比例或许要达到6成了。

无独有偶,在小鹏G9的大定订单中,超过80%的用户选择了MAX版本。也就是说,每卖出5辆G9,就有4辆标配城市NGP高阶辅助驾驶。

无论青年、中年群体,开始有更多的人接纳智能驾驶了。

9月11日,工业和信息化部装备工业一司副司长郭守刚在“2023世界智能网联汽车大会”新闻发布会上透露:今年上半年,我国搭载辅助自动驾驶系统的智能网联乘用车市场渗透率近一步提升,达到了42.4%。

大家总说,汽车的上半场是电动化,下半场是智能化。现在看来,智能化渗透率之快甚至要超过新能源的渗透率。

这场“球赛”必须得踢,而且还要踢得漂亮。

小鹏G9、问界M7的“起死回生”之术,不能说完全由智驾推动,但这两家品牌的智驾实力,确实功不可没。

再往下走,多家车企都公布了自己的“智驾开城计划”。这场浪潮还要继续奔涌的话,必然要真正越过成本这道大关。

解决了成本问题,才能解决普及问题,而智驾普及是穿过“恐怖谷”的前提。

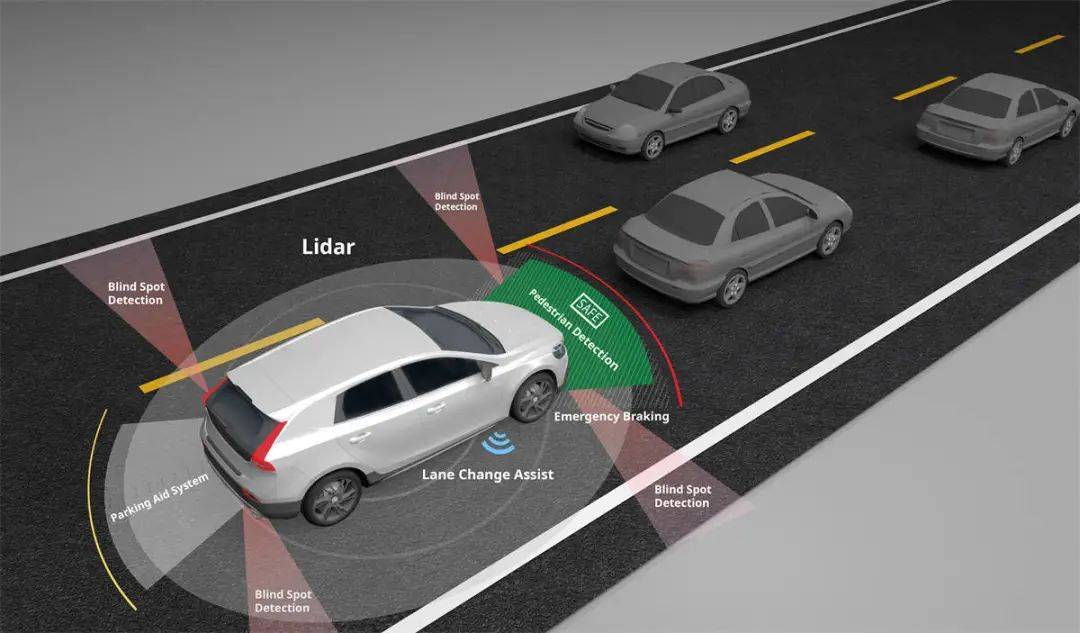

就自动驾驶系统而言,主要有3个组成部分:感知、规划、控制。

感知部分,经常会提到各种传感器(摄像头、激光雷达、毫米波雷达、超声波传感器等等,如今又衍生出了4D毫米波雷达),主要是对周围环境进行感知,并且转化为数据和信息。

最初,国内的自动辅助驾驶技术大多依赖高精地图和激光雷达。一些车企也把激光雷达当作智能驾驶的“入场券”,摇旗呐喊。

一时间,激光雷达炙手可热。今年2月,激光雷达的头号玩家禾赛科技在纳斯达克敲钟上市,2023年第一季度营收4.3亿,已是较为可观了。

但激光雷达还是贵了!

参考沙利文咨询公司的数据,机械式激光雷达的价格预计将从2021年的5500美元均价逐步下降到2027年的2500美元;MEMS和3D Flash/OPA激光雷达(去机械化)将从2021年的1000美元均价下降到2027年的500美元;FMCW激光雷达将在2025年首次上车,均价将从2025年的1000美元下降到2027年的500美元。

但你仔细看了,比较明显的降幅预计在2027年发生。即使如期下降,激光雷达仍是很贵的一个零部件。

而且,激光雷达到底用没用上,用了多少,这是又一个话题了。但行业里已有观点“冒头”,激光雷达在智驾中的重要性正在弱化,会仅仅担当“验证真值”和“盲区补盲”的作用。

智驾系统的成本一定要降,踢馆的选手也接踵而至。

低价位的平民车型上,逐渐出现了好用的L2级智驾解决方案。比如,宏景智驾宣布只用摄像头和超声波传感器就能实现L2级辅助驾驶,成本还很可观,只要2000-3000元;而大疆和五菱的组合,更把智驾战场拉到了15W以下的价位。

至于特斯拉,一直奉行低成本解决方案。早在2021年,它就干掉了北美市场部分车的毫米波雷达和超声波传感器,采用纯视觉的智驾方案。

行至此处,行业也在不断反思,堆砌硬件、设法融合,到底是不是过头了?

原来的逻辑很简单,在行业初期,车企为了尽快布局、市场抢位,硬件堆满,必然颇有故事可讲,尤其担心某个传感器失效,至少其他传感器也可以产生数据。

但这么多年实践下来,堆料并不意味着“本事就大”,反而,传感器一多,融合的难度更大了。

再说回“根儿上”的成本问题,它正驱使着部分车企逐渐舍弃价格昂贵的激光雷达,往纯视觉方案转向,但这对数据处理和算法设计的要求俨然更高了。

就这么短短几年,自动驾驶发展很快。回顾三年前,设定导航、自动变道的高速NOA还是稀罕物,再看看今年,已经开始推广城区智驾,“无图”、“开城”皆是火热的赛道。

我们关于自动驾驶的知识,也需要不断更新了。比如,激光雷达、摄像头的路线之争,还在继续,但也不像几年前那般完全笃定了。

最终的答案,还不见终局。

至少,大家开始关心更深处的决定因子,比如对算法的迭代,哪怕是宣传口,也开始踏足这个不太能给用户讲明白的内容。

这说明,自动驾驶开始进入“深水区”了。

目前,就自动驾驶系统而言,分化出2大技术路线:模块化和端到端。

模块化设计将自动驾驶拆分为众多模块,每个模块的算法不尽相同,基于规则的代码程序控制,或者由训练好的机器学习或深度学习模型控制。

这就很考验算力和算法,在车辆行驶过程中,实际情况非常复杂,限制条件很多。当越来越多的模块采用深度学习网络时,将彻底引爆计算需求,这几乎是一片填不满的“算力海洋”。

而端对端将自动驾驶当作一个整体,并不切分模块,可以做到将感知、规划和控制一体化。

传感器采集数据信息传送到神经网络,神经网络直接输出自动驾驶的指令。

前段时间很火的ChatGPT,就是一个典型的端到端的例子,输入语句,直接就得到答复。

也就是说,端对端相当于一个聪明的大脑,但是天才也需要努力学习,才不致于“伤仲永”。

对于自动驾驶来讲,想要得到精确的处理结果,前期就需要海量的数据来进行深度学习。

看罢前面的描述,至少有一种感觉吧?“端到端”更简洁,既节省计算资源,又消除级联误差,多个小模型,最终变成了一个大模型。

能实现这种跨越,BEV+Transformer起到了关键作用。

BEV是鸟瞰图,说得直白些是“上帝视角”,由此具备了深度信息,相较于平面2D图,所承载的信息更加丰富,可以将图像空间“翻译”到向量空间。

再加入Transformer,可以按照时间序列,给不同的特征和信息赋予权重,更好完成比对多路摄像头的特征,以达成一致的结果,借此实现更准确的感知识别效果。

BEV+transformer,已经能形成高质量的3D感知结果了。而这种优质的原始数据,才让“端到端”落地成为现实,也使得高精地图成了舍弃的对象。

是的,从有图到无图,就这么快速扭转了认知。当然,成本也降低了。

下一个要舍弃的会是激光雷达吗?occupancy占用网络可识别异形物体,似乎也让这种可能性成为现实。

但激光雷达的“下车”会比较遥远,因为它像“多一个安全气囊”一样,在用户心智中,正与安全牢牢地绑定在一起。

前文也说了,智驾普及的一种方式,就是讲安全。安全,更易动人心。

冒然砍掉激光雷达,绝对是冒险行为。除非,技术真的再突破,又经历一轮心智建设,以场景力证的方式,告诉用户,原来不用激光雷达,同样是那么安全。

但不必着急了,如果技术达到了,舆论扭转并不难。况且,激光雷达也能做“溢价”款型,倒也不是没有故事可讲。

前几年,智能驾驶,还像是PPT演练。今年开始,智能驾驶已渐成气候,真正从空中楼阁朝着购买动因做转变。

比起今年常规的降价促销,这张技术牌,倒是给各位厂家提供了不错的新思路。