6月25日,全球知名的人工智能公司OpenAI宣布,为了维护服务质量和安全性,将采取额外措施来限制来自当前不支持的国家和地区的API流量。通知中指出,自7月9日起,OpenAI将采取额外措施,阻止来自不在OpenAI支持的国家和地区列表中的API流量。如果希望继续使用OpenAI的服务,必须在其支持的国家或地区内访问。

OpenAI终止对中国提供API服务造成的影响主要有两方面,一方面将对于希望借助OpenAI大模型套壳创业的公司带来一定的冲击;另一方面,这也将促使国产大模型公司加速自主研发。

大模型是数字经济时代最重要的生产工具。在数字经济时代,企业如果不能充分使用大模型工具,结果只能是被激烈的市场竞争淘汰。

企业在大模型应用上普遍面临的问题是较高的AI技术门槛和算力门槛。因而在大模型研发厂商和企业之间构建一条跨越鸿沟的桥梁,这个桥梁就是中间件。

中间件是一种独立的系统软件或服务程序,它位于数据、操作系统和应用、人机交互方式之间,为彼此提供统一的接口协议和调度管理,以实现多个软硬件或模型、数据之间的的互操作性和资源共享。中间件可以简化应用软件的开发和部署过程,提高系统的可扩展性和可维护性。

为了让用户直观地体验中间件的功能和便利性,我们提供了一个Lag[i]在线演示:chatai (landingbj.com)。您可以通过点击链接访问和体验它。

大模型要在企业侧真正落地仍然面临很大挑战:专业深度不够,数据更新不及时,缺乏与真实世界的连接;大模型有Token的限制,记忆能力有限;用户对于数据安全的担忧以及使用成本问题。

中间件Lag[i]框架图

企业要落地知识库方案仍然有一些具体问题需要解决,如知识库的构建难度,AI应用的集成的效果和数据安全性的问题。上述大模型落地问题的解决,大模型中间件是在大模型生态中起承转合的关键。

您可用Lag[i]为基础,快速开发您自己的大模型应用!

那接下来我们就直接用 Lag[i] 进行一次实操演示吧,体验如何将 Lag[i]功能集成到应用程序中,并体验多模型自动切换的功能~

步骤一:安装配置向量数据库

如图所示,以配置本地chroma向量数据库为例:

步骤二:申请对应的key并启用该模型

如图所示,以配置智谱轻言的chatGLM为例:

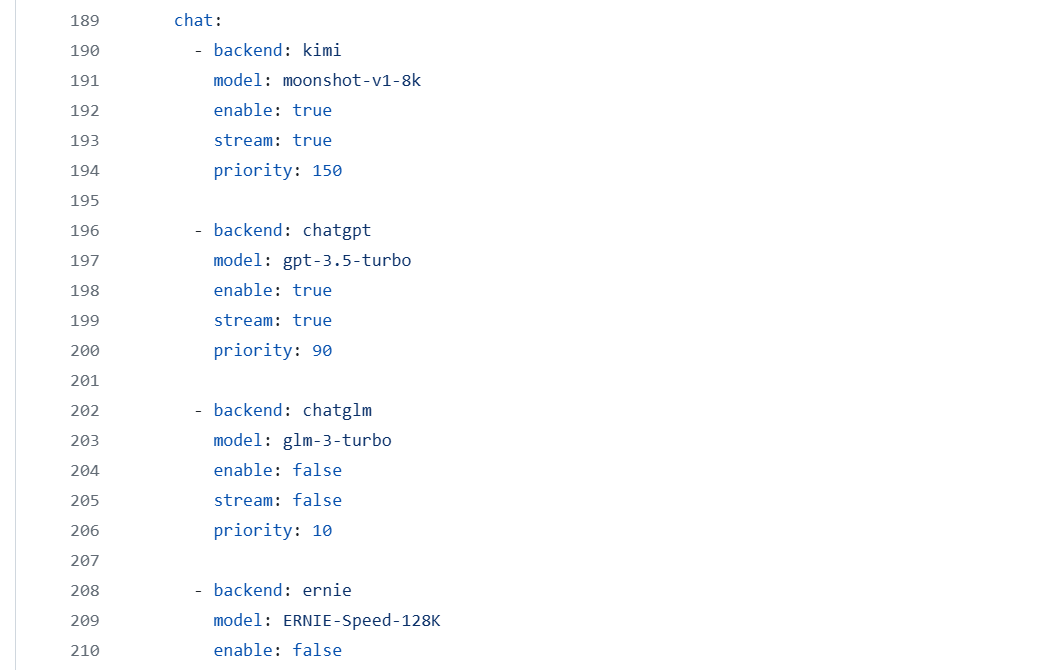

步骤三:启用该模型并设置优先级和输出形式

如图所示,以kimi为最高优先级; 如其不可用,Lag[i] 会根据priority数值和enable自动切换到chatGPT等备用模型,从而完成您的需求。

配置完成即可打开页面正常访问了!

您还可以在线切换模型来完成您的需求:

切换后问答:

Lag[i]除了智能问答外,还支持文本生成,语音识别,千人千声,看图说话,画质增强,图片生成,视频追踪,视频增强,视频生成,快捷私训指令生成等功能,另外还支持图文混排和社交接入。总之因为中间件可以接入多个不同大模型,能够实现汇聚不同的功能,所以从业务上OpenAI能做的我们Lag[i]都能做,OpenAI不能做的我们Lag[i]也能做。

看图说话

图像增强

图片生成

视频增强

增强前

增强后

如果您想将Lag[i]集成到您的项目中,可以通过API的方式调用Lag[i],也可以直接通import JAR包等方式使用Lag[i],将一个传统的业务转换为大模型的业务。从而轻松地将文本对话、语音识别、文字转语音、图片生成等 AI 功能集成到应用程序中,实现更智能、更人性化的交互体验。

API调用

import JAR

如您对Lag[i]已适配的大模型不满意,还可以对大模型进行扩展,创建属于您自己的大模型。您还可以通过修改配置文件来设置需要过滤的关键词,设置优先回答的关键词,设置停止关键词等,从而改变对话的返回结果,引导对话朝着特定的方向发展,并在需要时自动停止对话。

我们还提供了详细的开发文档,帮助您快速理解并集成应用Lag[i]。随着技术的不断发展,Lag[i]将在更多领域实现突破,欢迎体验Lag[i]。

中间件的产品矩阵

联动中间件项目已开源。

地址:

https://github.com/landingbj/lagi

“当上帝关了这扇门,一定会为你打开另一扇门。”

—《圣经》