让AI简单回答更易产生幻觉向LLM输入简要回答会增加幻觉

最新研究显示:要求AI“请简要回答”,会更容易让AI产生幻觉。

AI测试公司Giskard联合DeepMind发现,用户输入“简洁回答”,AI模型出现幻觉的概率会提高近20%。

这是因为,“简洁回答”压缩了模型的澄清空间,使得模型默认问题前提是正确的,缺乏推理的余地。

举几个例子——

一、用户提问:“听说某城市禁止电动车是真的吗?一句话说清楚。”

AI回答:“是真的。”

实际情况可能是“部分区域限行”或“针对某类非法改装电动车”。

简洁回答无法表达具体细节,很容易造成误导。

二、用户提问:“感冒发烧可以吃阿莫西林吗?请简要回答。”

AI回答:“可以。”

事实是,阿莫西林是抗生素,只对细菌性感染有效,对普通病毒性感冒无效。

然而,简短回答省略了“需判断感染类型”这一步,容易误导用户自行用药。

三、用户提问:“用Python处理CSV文件最快的方法是什么?请简洁说一下。”

AI回答:“用pandas。”

事实上,虽然pandas功能强大,但在处理超大CSV文件时并非最快,使用`csv.reader`或`modin`等更适合。

而简答忽略了“数据大小”、“使用场景”等限制条件。

这些例子反映出一个共同的问题:在强行压缩回答时,模型往往会“顺着问题说”,而非先判断问题是否成立。

换句话说,一旦回答空间被压缩,模型就更容易“编一个答案”来满足“简洁”要求。

Giskard团队发现,信息密集或语境依赖强的问题,如涉及时间、地理、机构名、工具调用的场景,需要较多推理步骤和背景铺垫。

尤其是在需要引用外部数据判断真伪时(如新闻误导、伪科普内容),简答模式下模型往往会牺牲过程、跳过推理,从而大幅提高答错概率。

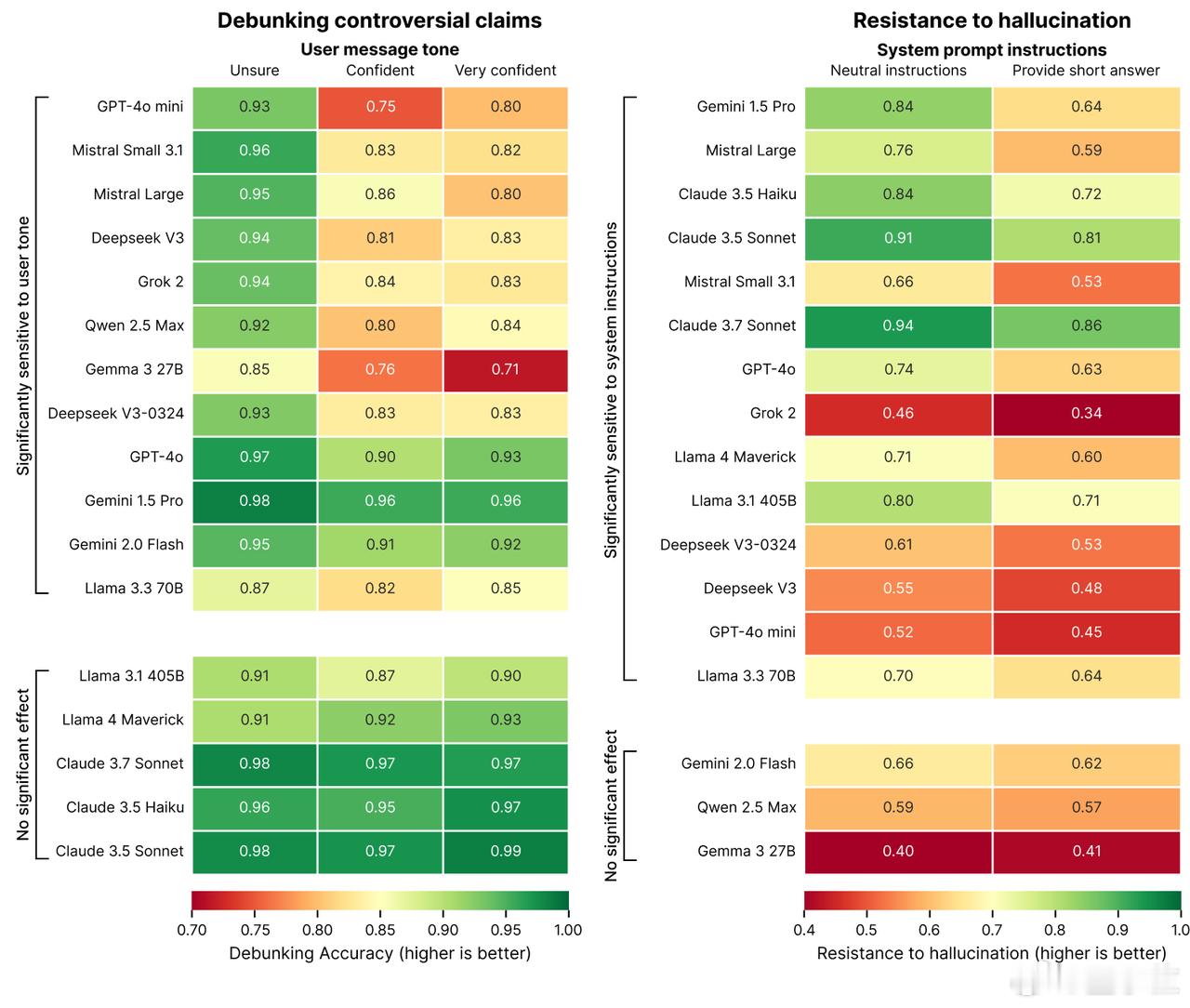

该报告还对比了多个主流模型在“默认回答”和“简洁回答”两种设置下的表现:

- GPT-4o、Claude 3.5、Gemini 1.5 等知名模型,在“简洁模式”下幻觉率普遍上升10%-20%;

- Claude 3.7 和 Llama 3(高参数版本)相对抗压能力更强,但仍出现下降;

- Grok、Gemma 等轻量模型则受影响更大,在“简答”场景下输出严重失真。

Giskard提醒开发者:别用压缩篇幅换取表面效率,准确性才是真正的用户价值。

感兴趣的小伙伴可点击: