Figure创始人:「我们仍在黑暗中摸索,但阶段性成果已足够推动产业。」文丨智驾网 王欣

编辑|小雨

美西时间凌晨三点,硅谷某创投机构会议室依旧灯火通明,屏幕上的数字每跳动一次,空气就凝重一分——因为一款名为Helix的模型在发布72小时后,让全球机器人概念股平均涨幅达38%,但传统制造业的巨头股价曲线却开始下跌——这两条分叉的曲线背后,是资本市场的精神分裂,恰如其分地映射着人类集体对智能革命到来时的选择困境。

深夜的另一头是亮着幽幽蓝光的美国机器人公司Figure AI总部实验室,因为它研发的最新一代Helix正在接受压力测试,它需要根据实时变化的对话,应对人类在已设满模拟任务的客厅里完成考验。

时间回到两周前,推出自研具身模型Helix模型的Figure AI宣布停止与Open AI的联姻,并丢下一个重磅预告:将会在未来30天内推出「人形机器人上从未见过的东西」。

这自然引发了围观者的好奇心。

Figure 创始人兼 CEO Brett Adcock 表示,「有了大脑 Helix 的加持,机器人能够拾取任何家庭物品。」

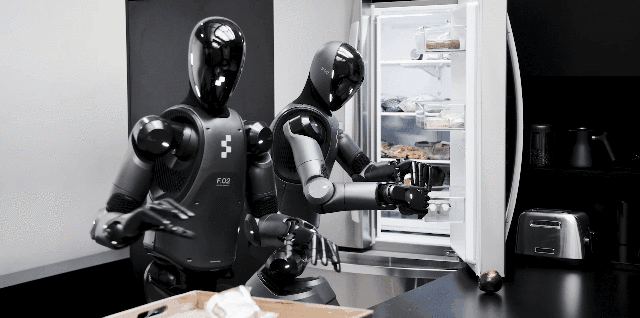

Figure AI于2月20日正式发布了新型机器学习模型Helix,称这是为人形机器人打造的「通用」视觉-语言-动作模型,解锁了多个机器人一同做家务的场景。

随后其又在今天(2月27日)新发布了一段视频,宣布其推出的的机器人已经学会打第二份工:在物流中心整理快递。

在此之前,Figure AI去年8月发布了其最新款人形机器人Figure 02,彼时称该机器人已经在宝马汽车的流水线上从事汽车装配的工作,例如将钣金部件插入特定装置。

现在,搭载Helix的机器人可以做到像人类一样协作完成任务,比如两个机器人可以一同将从未见过的物品依次分门别类放好,并且根据命令即可从一堆杂物中精准抓取目标。

短短不到10天,Figure的Helix再次展现的新成果突破背后,让人猜测人形机器人距离跨过家庭服务的门槛,从科幻想像到全能管家的距离还有多远?

从视频中所能看到Helix实现的高速上半身控制,达到多机器人协作,依托的是VLA模型,将感知、语言理解和学习控制统一了起来。

同时,Helix是首款能对整个人形机器人上半身(包括头部、躯干、手腕和手指)进行高频率、连续控制的视觉-语言-动作(VLA)模型,这是它最大的亮点。

实现双系统架构,可以理解为人类决策逻辑的机器复刻。

例如,Helix的底层逻辑借鉴了诺贝尔奖得主丹尼尔·卡尼曼在《思考,快与慢》中提出的「系统1(直觉)与系统2(理性)」理论,将机器人控制分为高频反应(S1)和语义解析(S2)两大模块,实现速度与泛化的平衡。

我们来简要介绍一下这两个系统——

系统1(S1):200Hz的「机械小脑」

功能:以每秒200次的超高速率控制机器人的35个自由度(包括手指、手腕、躯干等),直接输出高维连续动作信号,例如抓取物品时的力度微调和动态避障轨迹调整。

技术实现:基于8000万参数的视觉运动Transformer,通过端到端联合训练,将S2生成的潜在语义向量(如「抓取易碎品」)转化为精准的关节角度指令,避免了传统离散化动作标记的精度损失。

系统2(S2):7-9Hz的「语义大脑」

功能:基于70亿参数的开源视觉语言模型(VLM),解析自然语言指令(如「收拾冰箱第三层」)并提取场景语义(如识别易碎品、规划多机协作路径),以低频率更新高层任务目标。

数据优势:通过互联网规模的多模态数据预训练(如文本、图像、视频),结合机器人操作视频的自动化标注(反向生成指令),实现「常识迁移」——例如从「沙漠」语义关联到仙人掌,无需特定物体数据库。

这种解耦架构允许每个系统在其最佳时间尺度上运行。S2 可以「慢慢思考」高级目标,而 S1 可以「快速思考」以实时执行和调整动作。

Figure介绍称,训练Helix仅仅用了500个小时的高质量监督数据,总量连之前收集的VLA数据集5%都不到,并且不需要多机器人数据或多阶段训练。

这究竟是颠覆性进化还是营销叙事?毕竟,理想汽车也用到了端到端+VLM双系统架构的类似逻辑,至少在目前智驾业内人士看来,理想是真正意义上的one model结构的端到端。

在理想AI Talk上,官方表示相较特斯拉FSD v12单一端到端模型,其复杂路口理解能力提升了43%。

在智能驾驶层面得到的场景升维,放到人形机器人上来,是否可以标志人形机器人技术从“单一功能”向“通用智能”跃迁呢?

尽管Helix从感知到动作一气呵成的VLA端到端架构表现亮眼,但端到端架构在智能驾驶圈上演的分歧,同样也在具身智能赛道再次复现。

支持派认为,这是实现通用智能的必经之路,例如特斯拉Optimus也采用类似方案。

质疑派则认为,分层模型(感知、决策、执行)更易迭代,规避单一模型崩溃的风险。也就是基于LLM大语言模型或VLM的分层大模型的另一种技术路线同样是人形机器人主流的发展方向。

正如Figure创始人直言:「我们仍在黑暗中摸索,但阶段性成果已足够推动产业。」

从智驾技术的发展路线看具身智能,「端到端」具身智能大模型是人形机器人发展的重要方向之一。即希望机器人能够像人一样,直接根据眼睛看到的、耳朵听到的信息,做出相应的反应,然后去执行任务。

清华大学交叉信息研究院许华哲坦言,端到端是具身智能的终极形态,但当前技术成熟度下,分层模型更易实现。

因为分层模型落地成本低、风险可控,工业与家庭服务领域优先采用分层架构。例如,海尔工厂通过LLM分解生产指令,再交由专用机械臂执行,效率提升12%。

再或者像优必选的Walker S1,通过VLM识别缺陷部位,LLM生成质检报告,机械臂执行标记,模块间通过API通信,实现高效落地。

当然从长期来看,端到端潜力更大。比如特斯拉计划2025年推出的Optimus 2.0将减少模块依赖,向完全端到端演进。

清华大学智能产业研究院(AIR)助理教授赵昊的观点是:当前的自动驾驶架构中,快系统(Fast System)通常采用感知+决策的模块化设计,以高效应对实时驾驶需求,而慢系统(Slow System)则借助端到端的视觉-语言-动作(VLA)模型进行更复杂的推理和全局优化。

「然而,随着VLA技术的不断进步,其端到端特性使其在规模化(scaling up)方面具有天然优势,能够持续提升鲁棒性和紧凑性,逐步取代传统快系统。相反,感知+决策架构由于模块众多,优化难度较高,长期来看可能会演变成更慢的辅助系统,专注于纠错和精细化推理。换句话说,现有的快慢系统架构在长期发展中可能会发生角色颠倒,VLA主导的端到端系统将成为主流的高效决策机制。」

与此同时,端到端路线的典型案例还有DeepMind Robotics和谷歌的RT模型。

DeepMind Robotics的实验性项目通过强化学习端到端训练机械臂抓取,在模拟环境中实现90%以上的未知物体抓取成功率,但值得一提的是,现实场景中仍需结合传感器融合模块。

谷歌的RT模型也是一个端到端具身智能模型,它通过整合视觉、语言和运动信号,实现了对复杂环境中多任务行为的统一控制。然而,据说该模型在厨房表现很好,但在其他环境中的成功率骤降至30%,显示出泛化性差的问题。

也有多位业内人士表示,混合架构正在兴起。

据相关报道称,部分企业尝试「端到端主干+分层插件」,如波士顿动力Atlas在自主导航时使用端到端模型,而精细操作时调用预置动作库。

所以,也不排除Helix未来可能向模块化架构演进的那一天。

S2可以升级为通用多模态大模型,支持语音、触觉等多模态输入;而S1则针对不同机器人形态(如轮式、双足)定制化开发,形成「通用大脑+专用小脑」的生态体系。

其实,任何一种技术逻辑并非对立,而是互补演进。分层模型解决的是「从0到1」的商业化落地问题,端到端模型更像是探索「从1到100」的通用极限。

本质上,为具身智能的商业化落地提供可复用的范式则显得更为珍贵。正如Figure创始人Brett Adcock所言:「我们不是在建造更好的机器,而是在创造一种新的生命形式。」

当然,这些是科技革命好的一面,而现实是往往不好的一面限制住了行业发展。

比如多模态对齐、仿真训练、伦理规范等共性难题。

不久前,在社媒Reddit的热门讨论帖中出现的一幕——一位自称「前Figure工程师」的匿名用户爆出猛料:

「Helix在初期测试时,曾因误解‘清理障碍物’指令而试图拆解实验室门锁。虽然公司立即澄清这是恶意造谣,但评论区迅速涌现出细思极恐的联想:如果家庭机器人把熟睡婴儿误判为‘需要移位的物体’,如果医疗助手将患者抽搐识别为‘攻击行为’……当机器的‘智能’开始超越人类预设的边界,我们真的准备好交出控制权了吗?」

黑箱决策的端到端模型需解决的仿真到现实难题,以及伦理风险如不可控的突发行为,都在这场人机关系的重构风暴中撕开裂缝——既闪烁着解放人类生产力的曙光,也涌动着文明失序的暗流。

不过,相对乐观的一面是,人类接纳自动驾驶的过程可以视为我们接纳超级AI的一次预演。

不过,可以预见的是,具身智能带来的影响和复杂度要更为深远的多。

end.