AI服务器迅猛崛起,带动HBM需求大幅增长。核心制程工艺创新,供给端新增产能释放,预计2024年HBM市场规模将快速增长。

HBM(高带宽存储)将多层 DRAM 垂直堆叠,通过 TSV 和 μbumps 连接逻辑芯片,实现小尺寸、高带宽、高速度。

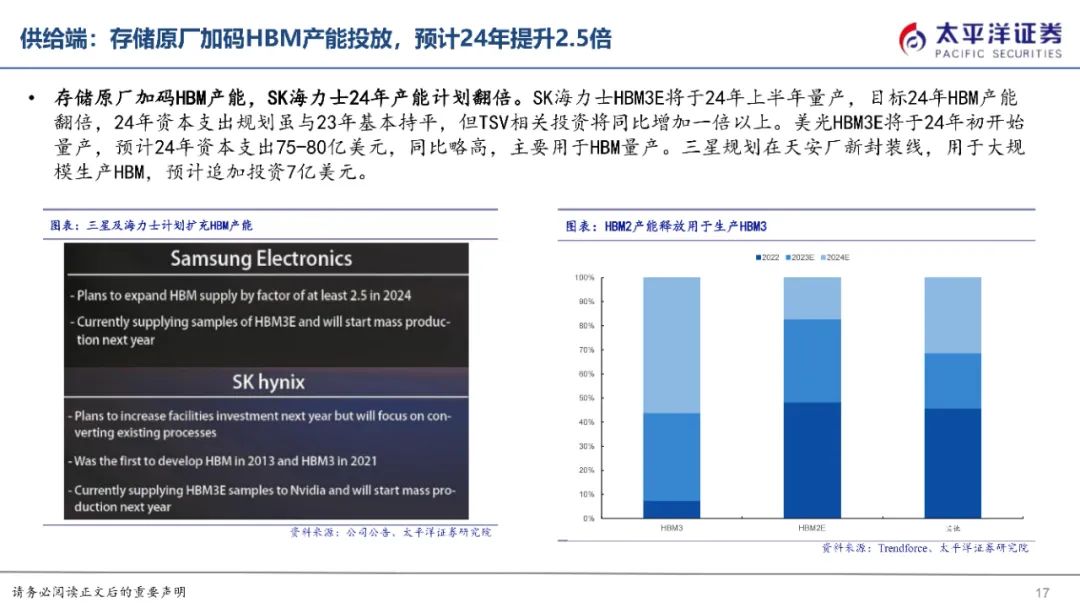

最新版本 HBM3E 由 SK 海力士推出,将于 2024 年量产,提供 8Gbps 传输速度和 16GB 内存。HBM 成为高性能 AI 服务器 GPU 显存的理想解决方案。

HBM(高带宽存储器)广泛应用于AI服务器,推动需求大幅增长。最新一代HBM3e已搭载于英伟达H200服务器中。

据Trendforce预测,到2026年,AI服务器出货量将达200万台以上,年复合增长率达29%。这将带动HBM市场需求爆发式增长。此外,随着服务器平均HBM容量的增加,预计到2025年,HBM市场规模将达到150亿美元,增长率超过50%。

HBM市占率由三大存储原厂主导:SK海力士 (53%)、三星 (38%)、美光 (9%)。工艺演变方面,CoWoS和TSV成为关键技术突破。

踏入芯时代,HBM正极速迭代,释放3D混合键合成设备的无限潜力。3D堆叠技术赋能人工智能、大数据等领域,成为产业变革的驱动力。

-对此,您有什么看法见解?-

-欢迎在评论区留言探讨和分享。-