HBM 高带宽存储突破性地堆叠 DRAM Die,实现小体积、高带宽和高速传输。采用 TSV 技术,将多层 Die 连接至逻辑 Die,提供高达 800GB/s 的带宽,满足高性能 AI 服务器 GPU 需求。

SK海力士发布HBM3E,提供8Gbps传输速度和16GB内存,将于2024年量产。HBM3E是HBM3的扩展版本,为高性能计算和人工智能应用提供突破性性能。

HBM(高速宽带存储器)以人工智能(AI)服务器为主要应用场景。最新一代HBM3e已搭载于英伟达2023年推出的H200中。根据Trendforce数据,2022年AI服务器出货86万台,预计到2026年将突破200万台,年复合增长率达29%。

AI服务器激增带动HBM需求飙升,平均容量提升。预计25年市场规模达150亿美元,增长超50%,潜力巨大。

HBM供应市场由SK海力士(53%)、三星(38%)和美光(9%)三大存储巨头主导。关键工艺技术包括CoWoS和TSV,推动着HBM在性能和成本方面的持续优化。

2014年推出的HBM1由AMD与SK海力士联合研发。作为GDDR竞品,其独特架构提供128GB/s带宽和4GB内存,远超当时的GDDR5。

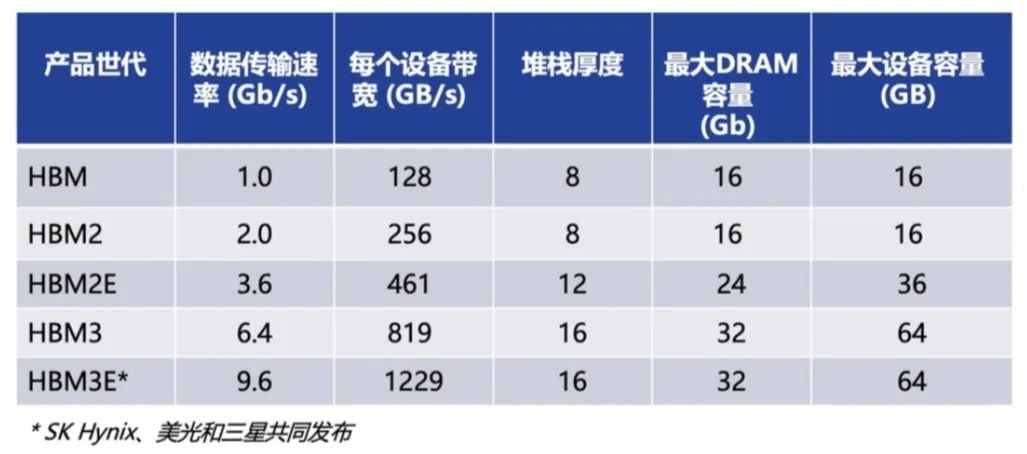

高速宽带内存技术的演进

自2016年以来,HBM(高带宽内存)技术不断革新:

* HBM2 (2018): 8层DRAM,提供256GB/s带宽,2.4Gbps传输速度,8GB内存。

* HBM2E (2020): 传输速度提升至3.6Gbps,内存增加至16GB。

* HBM3 (2022): 堆叠层数和管理通道增加,传输速度最高可达819GB/s,16GB内存。

* HBM3E (2024, 预计): 传输速度高达8Gbps,容量增至24GB。

HBM技术以其令人瞩目的带宽和容量,为高性能计算、人工智能和图形应用提供了强劲动力。

HBM,以其高带宽、低功耗、小体积的优势,成为 AI 服务器场景的不二之选。从 2016 年搭载 HBM2 的 NVP100 GPU 首次落地,到 2023 年英伟达发布的 H200 中配备 HBM3e,HBM 始终处于服务器技术的最前沿。

历经 HBM2、HBM2e 到 HBM3,每一代 HBM 都带来大幅性能提升和容量增加。最新 HBM3e 为服务器提供更快的速度和更大的容量,满足 AI 服务器快速发展的需求。

HBM市场由三大巨头主导:SK海力士(50%市占率)、三星(40%市占率)和美光(10%市占率)。SK海力士领跑,率先供应HBM3E,奠定市场地位。2023年,SK海力士预计市占率将升至53%,进一步扩大优势。三星主要供应云端厂商,市占率将降至38%。美光市占率预计为9%。

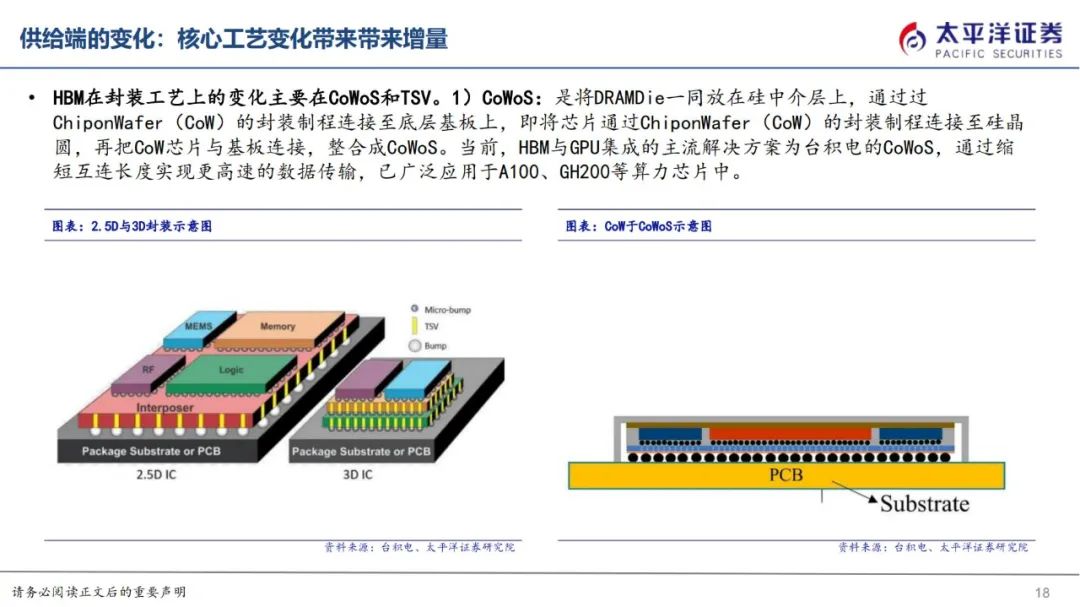

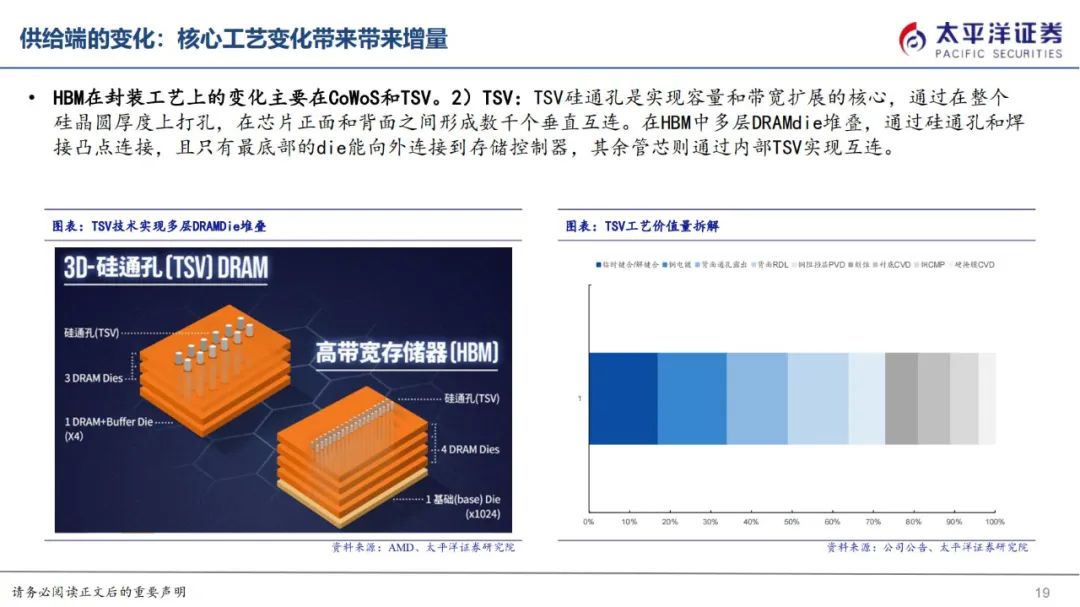

HBM在封装工艺上的变化主要在CoWoS和TSV。

CoWoS:芯片封装创新

CoWoS 是一种先进的芯片封装技术,将 DRAM Die 与底层基板整合到硅中介层上。它通过 ChiponWafer (CoW) 制程实现更短的互连长度,从而提高数据传输速度。

CoWoS 目前是高性能计算 (HPC) 芯片中 HBM 和 GPU 集成的首选解决方案。它已应用于 NVIDIA A100 和 GH200 等算力芯片,凭借其卓越的性能和可靠性,在 HPC 领域发挥着至关重要的作用。

TSV硅通孔是HBM的关键技术,通过垂直互连连接多层DRAM管芯,实现容量和带宽提升。TSV在硅晶圆厚度上打孔,形成正面和背面之间的通道,使所有管芯能够相互连接和向外连接,有效提高HBM的性能和效率。

-对此,您有什么看法见解?-

-欢迎在评论区留言探讨和分享。-