芝能智芯出品

人工智能技术的迅猛发展,对算力的需求急剧增加,尤其是大型语言模型(LLMs)和生成式AI应用的普及,推动了超大规模计算集群的建设。

由埃隆·马斯克创建的xAI项目通过与超微(Supermicro)的合作,迅速完成了拥有10万块NVIDIA H100 GPU的Colossus集群的建设,不仅在规模上刷新了业界纪录,还在液冷技术、网络架构、存储优化等方面展现了前沿技术。

Part 1

超微液冷技术助力高效计算

在当前的AI集群中,计算热量的管理已成为关键瓶颈。xAI选择超微作为主要硬件供应商的一个重要原因就是其先进的液冷技术。

传统风冷方式难以适应数万GPU并行工作的高热量需求,而液冷方案为这种密集的AI计算提供了有效的散热路径。每个Supermicro 4U液冷机架包含8个NVIDIA H100 GPU服务器,总计64块GPU,这种密集布局要求每个计算节点都能高效散热。

通过定制的液冷块,超微在机架层面上实现了水冷系统的精细控制。

与传统AI服务器仅对风冷系统加装液冷模块不同,超微的液冷设计完全从零开始进行硬件结构和散热路径的重塑。这种自上而下的冷却方案不仅在散热效率上远高于改装液冷系统,还大幅降低了设备的故障率与维护成本。

在xAI Colossus的数据中心中,每个机架配备独立的冷却液分配单元(CDU),并通过快速断开装置,使液冷系统的拆装更加简便,大大缩短了维护时间。

这种液冷方案的成功应用,不仅满足了当前集群的高热负荷,还为未来更高密度的集群布局提供了参考。

NVIDIA H100 GPU是目前最强大的AI计算芯片之一,而在xAI Colossus中,每个Supermicro服务器都配备了8个H100 GPU。通过Broadcom PCIe交换机的加持,这些GPU可以实现更高效的数据传输和计算性能。

超微的主板直接将四个PCIe交换机集成在液冷块上,无需额外的主板模块。这一设计有效减少了硬件体积和连接复杂性,显著提升了数据传输效率。

在多GPU协同工作的情况下,GPU之间的高带宽连接尤为重要,尤其是在处理大型语言模型(LLMs)和训练Transformer模型等数据量极大的AI任务时。

PCIe交换机提供了高速连接的桥梁,将不同GPU的运算资源高效整合。这种架构实现了GPU资源的最大化利用,使得集群在运行超大规模AI模型时依然保持高效、稳定的计算表现。

在AI集群中,数据传输速率对模型的训练时间和效率至关重要。

传统的数据存储方式采用的是磁盘阵列,而xAI Colossus采用了基于NVMe的全闪存架构。这种存储方式在功耗、存取速度和空间效率方面均优于传统磁盘存储。

闪存在成本上高于磁盘阵列,但其数据传输效率显著降低了集群的训练时间,从而在总拥有成本(TCO)上取得优势。

超微在设计NVMe存储节点时,与计算服务器保持了一致的外观和架构,这种“模块化”设计降低了管理的复杂度,也便于在数据中心内灵活配置和扩展。

这种存储架构能够快速响应海量数据存储和读取需求,为xAI Colossus的集群提供了极具弹性的存储支撑。

在如此大规模的集群中,网络架构的选择对整体性能至关重要。

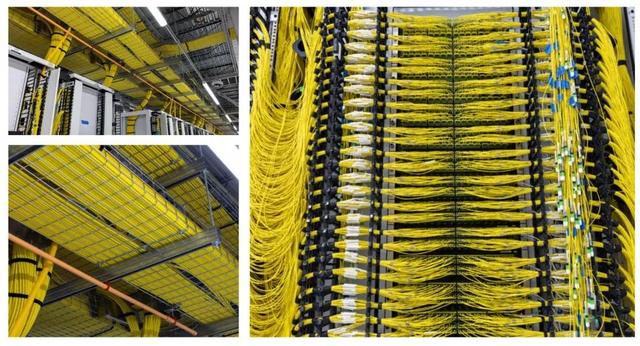

xAI Colossus采用了以太网技术,并利用NVIDIA的BlueField-3 SuperNIC与Spectrum-X网络构建了高达400GbE的连接速度。相比传统的1GbE网络,这种400倍的速度提升为GPU节点之间的通信提供了足够的带宽支持,使得训练任务能够在节点间迅速分布和整合。

BlueField-3 SuperNIC的使用解决了集群在并行运算时常见的数据瓶颈问题。通过RDMA技术,xAI Colossus能够在不同GPU之间实现高速数据共享,极大提高了AI模型训练的效率。

以太网技术在此起到关键作用,其极强的扩展性确保了Colossus集群可以灵活扩容,同时也适用于未来AI负载的快速增长需求。

Part 2

液冷网络交换机:

推进行业冷却技术创新

在参观xAI Colossus设施的过程中,液冷网络交换机的应用成为一大亮点。与传统的风冷交换机不同,液冷交换机通过共封装光学模块实现了更加有效的散热。

当前的高性能网络交换机不仅要处理高密度计算流量,还需要应对设备本身发热问题,这种液冷共封装设计在降低设备热量的同时,大大提升了网络设备的稳定性和寿命。

通过使用液冷交换机,xAI Colossus能够支持更高的网络密度和速度,也为未来AI数据中心的设备选择提供了新的可能性。

这种全液冷方案将逐步替代传统风冷交换机,有望引领未来AI数据中心在冷却技术上的全面革新。

xAI Colossus数据中心不仅展示了如何在短时间内部署超大规模AI集群,也为未来AI数据中心建设提供了重要参考。

这一项目的成功表明,高效的液冷系统、模块化的NVMe存储、以太网网络以及高性能的GPU计算节点构成了现代AI数据中心的核心要素。

此外,超微的定制化解决方案有效地将这些前沿技术整合在一起,充分展现了超大规模AI集群的设计理念和部署技巧。

未来AI数据中心的发展方向将进一步朝着低功耗、高计算密度和快速部署的方向演进。超微在Colossus项目中积累的技术经验,将在未来AI集群中广泛应用,为各类AI任务提供更强的算力支撑。

随着AI应用需求的不断增长,类似xAI Colossus这样的集群将逐步成为主流,推动AI技术的普及与应用。

小结

xAI Colossus集群的建成不仅为全球AI计算设施树立了新的标杆,还通过超微提供的液冷系统、NVMe存储方案以及高速以太网网络,展示了超大规模AI计算的可能性与未来发展方向。